2

Regressão Linear Simples (RLS)

Seja o seguinte modelo:

yi =

+ xi + ui

onde yi é salário, xi é educação. Este é um modelo de regressão linear simples.

Mas podemos ter outra variáveis que afetam yi ? Então vamos adicionar mais variáveis

ao modelo:

yi = + 1 x1i + 2 x2i + 3 x3i + ui

onde, x1i é educação, x2i é genêro e x3i é idade do indivíduo.

Nesta seção trataremos do primeiro modelo e na seção seguinte do segundo.

Então:

yi = + xi + ui

onde,

= intercepto;

=coe…ciente angular;

y =variável dependente (ou explicada, regredida, de resposta, controlada)

x =variável independente (ou explicativa, regressor, de controle)

u =erro, medida da ignorância

Suponha o seguinte modelo:

y=

onde

e

+ x+u

são os parâmetros (coe…cientes) verdadeiros:

Função de regressão Populacional (FRP): yi = + xi + ui

; são desconhecidos, mas supomos que existem. Assim a FRP é algo …xo, mas

desconhecido, na população de interesse.

A partir de dados de uma amostra estimaremos e , sendo ^ é um estimador de e

^ é um estimador de .

São estimadores não-viesados: E (^ ) = , E ^ = .

Entre os estimadores não-viesados, sobressaem-se os estimadores com menor variância.

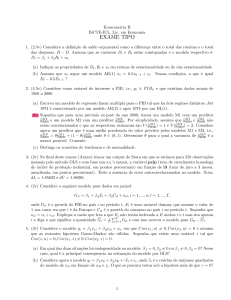

Graf ico

Função de Regressão Amostral (FRA): yi = ^ + ^ xi + u

^i

Necessitamos de uma amostra da população para estimar e .

Então ^ e ^ são os parâmetros estimados a partir de uma amostra.

Eu

^i é o resíduo.

Assim FRA é a versão estimada da FRP.

Veremos o método mais tradicional para estimar tais parâmetros na subseção seguinte.

6

2.1

Método de Mínimos Quadrados (MQO ou Ordinary Least Squares OLS)

Seja o modelo:

yi = ^ + ^ xi + u

^i

| {z }

y^i

onde y^i é o yi predito, previsto ou porção explicada e u

^i é o resíduo.

Graf ico

Qual critério devo utilizar para obter os estimadores?

Podemos minimizar:

1. Soma dos Erros: Não é um bom critério pois pode anular positivos e negativos.

2. Soma Absoluta dos Resíduos: Gera um estimador pouco utilizado denominado LAD

(Least Absolute Deviations)

3. Soma do Quadrado dos Erros: Tem propriedades estatísticas (que veremos adiante)

que o tornam bastante atrativo.

Então, devemos resolver o seguinte problema de minimização:

f ;

n

X

n

X

u2i = min

(yi

g

f ^ ; ^ g i=1

i=1

min

xi )2

As CPOs serão:

^:

2

X

yi

^ xi = 0 =)

^

i

X

u

^i = 0

i

Esta CPO nos mostra que a escolha do intercepto ótimo implica que a soma dos resíduos

será zero.

Continuando com esta CPO:

X

yi ^ ^ xi

= 0

X

i

i

yi

X

X

^

i

ny

^ M QO

^ xi = 0

i

^ nx = 0

= y ^x

n^

Este é o estimador de Mínimos Quadrados Ordinários do intercepto ( ).

7

(1)

Exercício 1 Prove que, em um modelo com intercepto, a reta da regressão (^

y ) sempre

passa pelo ponto médio (x; y).

Obtendo a CPO para ^ :

X

^: 2

yi

X

^ xi xi = 0 =)

^

i

u

^i xi = 0

(2)

i

Esta CPO nos mostra que a correlação entre o resíduo u

^i e xi é nula.

Observação 2 Podemos notar isso mais claramente se minimizarmos o modelo em termos

de desvios da média, ou seja:

yi = + xi + ui

Tomando a média, teremos:

y=

+ x

(A média dos erros é zero: é uma das hipóteses que veremos na próxima seção).

Tomando a diferença entre as duas equações acima:

yi

y =

yi

(xi

=

x) + ui

xi + ui

onde, o sobrescrito * indica que a variável está especi…cada em termos de desvios da

média. Assim: minimizando:

min

n

X

u2i

= min

i=1

obtemos na derivação do :

X

yi

2

n

X

xi )2

(yi

i=1

^x

i

xi = 0 =)

X

u

^i xi = 0

i

i

Dividindo a última expressão por n 1 (considerando n > 1), teremos:

P

^i (xi x)

iu

= Cov (^

u i ; xi ) = 0

n 1

Ou de forma mais simples ainda, retome a CPO da equação (2) e note que:

X

u

^i xi = 0

X

i

i

u

^i xi

X

i

8

u

^i = 0

que não altera em nada a expressão, pois como vimos

constante x:

X

X

u

^i xi x

u

^i = 0

i

X

P

^i

iu

= 0. Multiplicando pela

i

u

^i (xi

x) = 0

i

Dividindo por n

1:

P

^i (xi

iu

n

x)

1

= Cov (^

u i ; xi ) = 0

Retomando a CPO (2) do ^ , temos que:

X

yi

i

X

yi xi

i

X

^

^ xi xi = 0

X

^ xi

i

yi xi = ^

i

X

X

X

i

xi + ^

i

yi xi = y

^x

i

X

X

X

x2i

i

xi + ^

i

yi xi = y

i

^

^ x2 = 0

i

M QO

X

xi + ^

X

x2i

i

X

P i

P i

xi

y

x

y

i

i

Pi

= Pi 2

x i xi

i xi

x2i

x

X

i

xi

!

h

( ^=y

i

^x )

Podemos escrever este estimador também de uma forma diferente. O denominador

9

pode ser escrito como:

X

(xi

X

x)2 =

i

x2i

i

X

=

x2i

i

X

=

2xi x + x2

X

i

x2i

2x

i

X

=

X

2xi x +

X

x2

i

xi + nx2

i

x2i

2xnx + nx2

x2i

nx2

x2i

xnx

x2i

x

i

X

=

i

X

=

i

X

=

i

E o numerador pode ser escrito como:

X

X

(xi x) (yi y) =

(xi

i

X

x) yi

i

=

X

(xi

X

xi yi

i

=

=

yi xi

i

=

X

X

(xi

i

x) yi

y

X

x) y

(xi

x)

i

i

X

xi

i

yi xi

i

{z

}

|

P

P

= i xi

ix

= nx nx = 0

X

X

X

xyi =

yi xi x

yi

i

P

P i

x

i i

i yi

n

X

X

xi y =

yi xi

i

pode ser escrito como:

P

x) (yi y)

i (xi

^

=

P

M QO

x)2

i (xi

i

i

y

X

xi

i

Assim, o estimador MQO do

Exercício 3 Obtenha o estimador MQO do a partir do modelo exposto na 2, ou seja,

continue a partir da CPO do problema já derivada.

10

O estimador MQO acima pode ser escrito também de outra forma usual; basta dividir

o numerador e denominador por n 1 e assim:

P

x) (yi y) =n 1

Cov (x; y)

i (xi

^

=

P

M QO =

2

V ar (x)

x) =n 1

i (xi

Exercício 4 Faça a Condição de Segunda Ordem (CSO) e mostre que o problema de

minimização da soma do quadrado dos resíduos resulta realmente em um mínimo. Dica=

monte a matriz hessiana e mostre que o determinante é positivo).

2.2

O Coe…ciente de Determinação: RLS

Existe alguma medida que me mostre se o meu modelo tem um bom poder preditivo?

Ou seja, se o regressor(es) (x) que eu inclui no meu modelo explica(m) bem a variável

dependente (y).

Seja a FRA:

yi = ^ + ^ xi + u

^i

| {z }

y^i

Tomando a média:

y = y^i

Assim, ambas as médias são iguais. Subtraindo y dos dois lados da FRA:

(yi

y) = (^

yi

yi

y) + u

^i

= y^i + u

^i

onde o sobrescrito * indica que a variável está especi…cada em termos de desvios em

relação à média. Assim temos:

yi = y^i + u

^i

Elevando ao quadrado:

(yi )2 = (^

yi )2 + 2^

yi u

^i + u

^2i

Somando a expressão para todas as observações da amostra:

X

X

X

X

(yi )2 =

(^

yi )2 + 2

y^i u

^i +

u

^2i

i

P

i

i

P

P

i

^P

^i = i ^ + ^ xi u

^i = ^ i u

^i +

^i = 0. Os dois termos são

Note que:

^i u

iy

i xi u

iguais a zero e vem das CPOs do e do (2). Assim:

X

X

X

(yi )2 =

(^

yi )2 +

u

^2i

i

i

11

i

onde:

X

(yi )2 = Soma dos Quadrados Totais (SQT)

i

X

i

(^

yi )2 = Soma dos Quadrados Explicados (SQE)

X

u

^2i = Soma dos Quadrados dos Resíduos (SQR)

i

Assim:

SQT = SQE + SQR

Dividindo a expressão por SQT , teremos:

1=

SQE SQR

+

SQT

SQT

| {z }

R2

O R2 mede o quanto da variação da variável dependente pode ser explicado pela variação

do regressor. Assim:

R2 =

R

2

onde R2 2 [0; 1].

=

SQE

=1

SQT

P

(^

y )2

Pi i 2 =

i (yi )

SQR

SQT

Pn

(b

yi

Pni=1

i=1 (yi

y)2

y)2

=1

Pn

P

^2i

iu

i=1 (yi

y)2

Observação 5 Esta expressão é válida apenas se o intercepto é íncluído no modelo. Caso

contrário, o R2 não pode ser mais utilizado pois não necessariamente ele estará no intervalo

[0; 1], podendo inclusive ser negativo. Sem intercepto, estamos forçando o modelo partir

da origem. Se o valor verdadeiro do intercepto, , for diferente de zero, então ~ será um

estimador viesado de .

Exercício 6 Prove que no modelo sem intercepto o R2 não estará necessariamente no

intervalo [0; 1].

Exercício 7 Mostre que no modelo com intercepto: yi = ^ + ^ xi + u

^i , o R2 = [corr (x; y)]2 .

12

3

Hipóteses do Modelo Clássico de Regressão Linear (MCRL)

Hipótese 1 (Linearidade dos Parâmetros) A relação entre a variável dependente y e

as explicativas x1 ; ::::; xk é linear:

y1 =

0

+

1 x1i

+ ::: +

k xki

+ ui

De…nição 8 Um modelo de regressão é linear nos parâmetros se as CPOs associadas ao

problema de obtenção dos EMQ (Estimadores de MQO) gerarem um sistema linear nos

parâmetros.

Exemplo 9 Seja o seguinte modelo:

yi =

+ xi + ui

Assim, o problema de minimização será:

X

min

(yi

;

xi )2

i

As CPOs serão:

^ :

2

X

yi

^ xi = 0 =)

^

^ xi xi = 0 =)

i

^ :

2

X

X

^

i

yi

i

yi = n^ + ^

X

P

P i x2i

i xi

i xi

b

b

=

yi xi = ^

X

i

P

P i yi

i yi xi

Logo é um sistema linear e o modelo é linear nos parâmetros.

Exemplo 10 Seja o seguinte modelo:

yi =

+ xi + ui

O problema de minimização é:

min

f ; ; g

A CPO:

:

2

X

(yi

2

xi )

i

X

(yi

xi ) = 0

i

Logo não é linear por causa do .

13

xi

i

i

Pn

X

xi + ^

X

i

x2i

Exemplo 11 Seja o seguinte modelo:

yi = x1i1 x2i2 eui

Tomando o ln, teremos:

ln yi = ln

+

1 ln x1i

+

2 ln x2i

+ ui

Portanto, o modelo é linear.

Hipótese 2 (Amostragem Aleatória) : Podemos extrair uma amostra aleatória:

f(x1i ; :::; xki ; yi ) ; i = 1; ::::; ng

da população.

Observação 12 Nos livros-texto esta hipótese é geralmente substituída por uma hipótese

de que X é não-estocástico (aleatório).

Hipótese 3 (Média Condicional Zero) : E (ujx) = 0

Exercício 13 Mostre que:

(i) E (ujx) = 0 =) E (u) = 0

(ii) E (ujx) = 0 =) Cov (u; x) = 0.

Dicas: Usem a Lei das Expectativas Iteradas (L.E.I): EX (EY (Y jX)) = E (Y ) e a

seguinte propriedade: E (Y XjX) = XE (Y jX).

Se Cov (u; x) = 0, dizemos que os regressores são exógenos e, assim, podemos seaparar

y em parte explicada e erro sem haver relação entre elas.

Se Cov (u; x) 6= 0, dizemos que os regressores são endógenos e teremos um problema

de endogeneidade no modelo que viesa os estimadores MQO (isto será visto em seção

posterior).

Exemplo 14

ln w =

+ educ + u

onde w = salario e educ = anos de estudo. Em u podemos ter diversas variáveis não

observáveis, como por exemplo: habilidades (cognitivas/não-cognitivas) de um indivíduo.

A habilidade de um indivíduo pode estar correlacionada com educação. Assim, o efeito de

um maior nível educacional no salário pode estar viesado pois indivíduos com maior nível

de habilidade é de se esperar que avancem mais nos ciclos escolares e, conseqüentemente,

obtenham um maior nível salarial.

14

Hipótese 4 (Não há Multicolinearidade Perfeita) : As variáveis explicativas 1; x1 ; :::; xk

são linearmente independentes. Logo, xj ; j = 1; :::; k; não podem ser constante.

2

6

6

6

X=6

6

6

4

1 x11 x21 : : : xk1

1 x12 x22 : : : xk2

:

:

:

:

:

:

:

:

:

:

:

:

:

:

:

1 x1n x2n

xkn

3

7

7

7

7

7

7

5

n (k+1)

Esta hipótese implica que posto (X) = k + 1, pois n k + 1.

Relembre das propriedades de algebra matricial que:

posto (X) = posto X 0 X = k + 1

Assim, (X 0 X) é uma matriz invertível pois possui posto pleno (ou posto cheio ou

máximo). Assim, 9 (X 0 X) 1 e portanto, podemos obter os parâmetros estimados:

X 0X

1

X 0X ^ = X 0Y

X 0X ^ = X 0X

^ = X 0X

Hipótese 5 (Homocedasticidade) : V ar (ui jx) =

constante.

1

X 0Y

1

X 0Y

2 ; 8i,

ou seja, a variância do erro é

Hipótese 6 (Ausência de (Auto)Correlação (Serial)) : Cov (ui ; uj jx) = 0; 8i; j; i 6=

j.

Hipótese 7 (n > k) : Número de observações maior do que o número de regressores.

Essa hipótese é importante para obtermos os EMQ.

Hipótese 8 (Normalidade) : ui

para inferência.

N 0;

2

15

para todo i. Tal hipótese será necessária

Hipótese 9 (O modelo está corretamente especi…cado) : Não podemos incluir no

erro variáveis que estejam correlacionadas com as demais variáveis explicativas, pois assim

violaríamos a H.3.

Assim, dadas estas hipóteses, podemos enunciar um teorema (que será mais adiante

provado), que mostra a importância do EMQ.

Teorema 15 (de Gauss-Markov) : Dentro da classe dos estimadores lineares e nãoviesados, e dadas as hipóteses do MCRL, os EMQ são os estimadores que possuem a

menor variância (BLUE - Best Linear Unbiased Estimator)

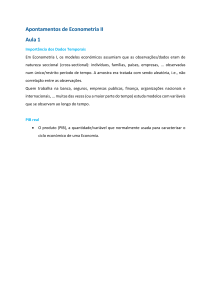

F igura

Agora, veremos, no caso da RLS, que:

(i) EMQ são lineares

(ii) EMQ são não viesados

(iii) Qual a variância dos EMQ?

(iv) Qual a Cov ^ ; ^ ?

(v) Quem é o "EMQ"de

2?

Proposição 16 (i) Os estimadores MQO ^ e ^ são estimadores lineares se puderem ser

escritos como uma combinação linear de y.

Prova. O estimador ^ é escrito como:

^=y

^x

Assim, sua linearidade depende de ^ .

P

P

P

x) (yi y)

x) y

x) yi

i (xi

i (xi

i (xi

^ =

=

P

P

2

2

x)

x)

i (xi

i (xi

P

P

P

P

x) yi y i (xi x) i (xi x)=0 i (xi x) yi

i (xi

^ =

=

P

P

x)2

x)2

i (xi

i (xi

"

#

X

(xi x)

^ =

yi =

P

x)2

i (xi

i

X

^ =

d i yi

i

onde, di =

(x x)

P i

2.

i (xi x)

Logo, ^ é um estimador linear.

16

Em relação ao intercepto:

^x =

^ = y

"

X 1

n

i

X

=

ci yi

=

P

i yi

x

P

(xi

Pi

n

i (xi

#

P

x i (xi x)

yi

P

x)2

i (xi

x) yi

x)2

i

onde, ci =

h

i

P

x i (xi x)

P

2

i (xi x)

1

n

=

1

n

xdi . Logo ^ é um estimador linear.

Proposição 17 (ii) EMQ são não-viesados.

Prova.

X

^ =

d i yi =

i

X

=

di ( + xi + ui )

i

di +

i

X

=

X

i

X

i

di +

di xi +

X

X

di ui

i

di xi +

i

X

di ui

i

Analisando o segundo e terceiro termo do lado direito da expressão:

X

di =

i

X

X

i

di xi =

i

1

(xi x)

P

2 = P

x)

i (xi

i (xi

x)2

X (xi x) xi

=

P

x)2

i (xi

i

X

|

i

(xi

x) = 0

{z

=0

}

P

P

P

(x

x)

(x

x)

=

(x

x)

(x

x)

=

(x

x)

x

Note

que

i

i

i

i

i

i

i

i (xi

i

i

P

P

P

x) xi x i (xiP x) = i (xi x) xi :P

i (xi

Assim, substituindo i (xi x) (xi x) = i (xi x) xi , acima:

P

X

i

Substituindo

P

i di

P

X (xi x) (xi x)

(xi

di xi =

= Pi

P

2

x)

i (xi

i (xi

i

=0e

P

i di xi

x)2

x)2

=1

= 1, de volta na expressão de ^ :

X

^= +

di ui

i

17

x) x =

Analisamos 2 casos aqui:

(1) X não-estocástico (não-aleatório ou …xo).

!

X

E ^

= E

+

di ui =

=

+

X

X

+E

i

di ui

i

E (di ui )

!

i

Como X é não-estocástico e di depende apenas dos regressores logo di é …xo também.

Logo:

X

E ^

=

+

di E (ui )

| {z }

i

E ^

=0

=

(2) X estocástico (aleatório). Neste caso devemos tomar a esperança condicional:

!

X

X

E ^ jx

=

+E

di ui jx = +

E (di ui jx)

=

+

X

i

E ^ jx

=

i

i

di E (ui jx)

| {z }

=0

Exercício 18 Prove que

P ^ é não-viesado. Dica: mostre primeiramente que ^ pode ser

escrito como: ^ = + i ci ui .

A partir de (i) e (ii) note a partir do seguinte modelo (FRA):

y = ^ + ^x + u

Tomando a esperança condicional:

E (yjx) =

+ x

Ou seja, o que estamos tentando modelar é o comportamento médio dos agentes (indivíduos, …rmas, governo, países etc).

(iii) Qual a variância dos EMQ?

18

^

0

=

0

X

+

ci ui

i

^

1

=

1

X

+

di ui

i

Assim:

V ar ^ 1 = E

^

2

E ^1

1

2

= E

^

= E

X

1

1

di ui

2

= E d21 u21 + d22 u22 + ::: + d2n u2n + 2d1 d2 u1 u2 + ::: + 2dn

=

d21 E

u21

| {z }

+

d22 E

u22

| {z }

2

+ ::: +

2

V ar ^ 1 =

2

X

u2n

| {z }

1 dn un 1 un

+

2

+2d1 d2 E (u1 u2 ) + ::: + 2dn

| {z }

0

d2n E

1 dn E

|

d2i

(un 1 un )

{z

}

0

i

Mas:

X

i

d2i

=

X

i

xi x

P

x)2

i (xi

!2

1

= hP

2

i (xi

x)

Substituindo na expressão acima, teremos:

V ar ^ 1 = P

i (xi

19

i2

X

i

2

x)2

(xi

1

i (xi

x)2 = P

x)2

2

V ar ^ 0 = E ^ 0

2

X

ci ui

= E4 0+

0

0

i

!2 3

5

= E c21 u21 + ::: + c2n u2n + 2c1 c2 u1 u2 + ::: + 2cn cn

= E

2

=

c21 u21

(un un

0

X

(xi x)2

(xi x)

B

2 61

2

+

x

P

4

@

P

n

n

(xi x)2

(xi x)2

3

2

P

P

2

2x

(xi x)

(xi x) 7

2 61

2

P

4

25

2 +x

P

n

n

(xi x)

(xi x)2

#

"P

1

(xi x)2 + nx2

2 1

2

2

+x P

=

P

n

n (xi x)2

(xi x)2

P 2

P

P

xi 2x xi + x2 + nx2

2

P

n (xi x)2

P 2

xi 2xnx + nx2 + nx2

2

P

n (xi x)2

P 2

2

xi

^

V ar 0 = P

:

n (xi x)2

13

i

c2i =

0

XB 1

@ 2

n

=

2

=

2

X 1

26

4

n2

i

=

=

=

=

=

1 un un 1

1E

X

+ ::: + E

c2n u2n

2

2

X

i

1

n

2x (xi

P

n (xi

+ 2c1 c2 E (u1 u2 ) + ::: + 2cn cn

!2

x (xi x)

P

x)2

i (xi

1

x2 (xi

x)

+

P

x)2

(xi

X 2x (xi

P

n (xi

i

x)2 C

2A

x)2

X x2 (xi

x)

+

P

x)2

i

(xi

2x X

(iv) Quem é Cov ^ 0 ; ^ 1 ?

20

2

x)

x)2

3

7

25

C7

2 A5

1)

Cov ^ 0 ; ^ 1

^ x; ^

1

1

= Cov y

^ x; ^

1

1

= Cov y; ^ 1 + Cov

{z

}

|

0

xCov ^ 1 ; ^ 1 =

=

Cov ^ 0 ; ^ 1

=

P

xV ar ^ 1

2

x

(xi

x)2

Observação 19 A variância para um vetor de variáveis é calculado como:

V ar (x) = E (x

E (x))0

E (x)) (x

onde x é um vetor coluna de tamanho n. Esta expressão é chamada também de matriz

de variância-covariância.

^

0

^

Assim, seja ^ =

o vetor de parâmetros. Então, no nosso caso teríamos:

1

V ar ^ = E

20

^

= E 4@ ^ 0

^

0

@

= E 4@

2

^

^

1

E ^1

^

E ^0

E

= 4

Cov ^ 0 ; ^ 1

2

2

= 4

AA

0

E

h

11

E ^0

6

= 6

4

^

0

P 2

2

xi

P

n (xi x)2

2

P x

(xi x)2

A

0

^

P x

(xi x)2

P

^

2

i (xi

x)

2

1

0

E ^

^

0

E ^0

0

^

^

2

E ^1

3

Cov ^ 0 ; ^ 1

5

V ar ^ 1

3

2

E ^0

V ar ^ 0

^

E ^0

E ^1

1

1

20

E ^

5

21

h

^

5

E ^0

0

E

E ^1

3

E ^1

1

E

i

E ^0

1

^

1

^

5

E ^1

1

E ^1

3

2

i 3

7

7

5

(v) Estimador "MQO"de

2

(variância do erro):

yi = y^i + u

^i

yi

y = y^i

y+u

^i

Retomando a FRP (Função de Regressão Populacional) temos:

y i = + xi + u i

y = + x+u

yi

y=

(xi

x) + ui

u

Retomando a FRA (Função de Regressão Amostral) temos:

y^i = ^ + ^ xi

y = ^ + ^x

y^i

y = ^ (xi

x)

Logo:

u

^i = (yi

X

y)

u

^i =

(xi

u

^i =

^

u

^2i =

^

|

(^

yi

x) + ui

y)

u

^ (xi

x)

(xi x) + ui u

X

2X

(xi x)2 +

(ui u)2

{z

}

{z

} |

B

A

Tomando a esperança, para obtermos E

P

22

u

^2i .

2 ^

|

X

(xi

{z

C

x) (ui

u)

}

Assim, analisando termo a termo:

3

2

!2 P

P

2

(x

x)

u

(x

x)

i

i

i

5

E (A) = E 4 Pi

(^

2

(x

x)

i

i

2

3

P

P

(xi x) ui )2 (xi x)2 7

6(

= E 4 Pi

5

2

2

(x

x)

i

i

hP

i

2

E

(

(x

x)

u

)

i

i

i

1

= P

2

x)

i (xi

h

i

2

E

((x

x)

u

+

:::

+

(x

x)

u

)

1

1

n

n

1

= P

x)2

i (xi

3

2

(x1 x)2 u21 + ::: + (xn x)2 u2n +

1

5

4

= P

2 (x1 x) u1 (x2 x) u2 + :::

2E

(x

x)

i

i

+2 (xn 1 x) un 1 (xn x) un

i

h

1

2 2

2 2

= P

(x

x)

+

:::

+

(x

x)

1

n

x)2

i (xi

"

#

X

1

2 2

= P

(xi x)

=) E (A) = 2

2

x)

i (xi

i

23

=

P

i di ui )

Em relação a B:

E (B) = E

=

=

=

=

=

=

=

(ui

1)

2

u)2

X

u2i + u2 2ui u

X

X

X

E

u2i +

u2 2u

ui

X

E

u2i + nu2 2unu

X

E

u2i nu2

!

P

2

X

u

i

E

u2i

E n

n

X

2

1 X

ui

E u2i

E

n

h

i

1

n 2

E (u1 + ::: + un )2

n

1

n 2

E u21 + ::: + E u2n

n

2

n 2

= E

=

X

E (B) = (n

Em relação a C:

h

i

X

E (C) = E ^

(xi x) (ui u)

" P

!

#

x) ui X

i (xi

= E

(xi x) (ui u)

P

x)2

i (xi

2

(x1 x)2 u21 + ::: + (xn x)2 u2n + 2 (x1 x) (x2

6

+2 (xn 1 x) (xn x) un 1 un

6

= E6

P

4

x)2

i (xi

=

=

1

i (xi

P

1

P

i (xi

E (C) =

x)2

2

x)2

2

x)2

(x1

X

i

(xi

2

+ ::: + (xn

x)2

!

24

x)2

2

x) u1 u2 + :::

3

7

7

7

5

P

Substituindo as expressões em E

E

E

X

X

u

^2i

u

^2i , teremos:

= E (A) + E (B)

2

+ (n

= (n

2)

=

u

^2i

1)

2E (C)

2

2

2

2

Então um estimador não viesado para a variância do erro (

P 2

u

^i

SQR

2

^ =

=

n 2

n 2

2)

será:

pois vimos que:

E ^2 = E

P

u

^2i

n 2

=

1

n

2

E

X

u

^2i =

1

n

2

(n

2)

2

=

2

Veremos em regressão múltipla que, de forma geral:

P 2

u

^i

SQR

2

^ =

=

n k 1

n k 1

onde k é o número de regressores. Como estamos tratando de regressão linear simples,

então k = 1.

Teorema 20 (Gauss-Markov) Dadas as hipóteses do MCRL, dentro da classe dos estimadores lineares e não-viesados, os EMQ são os que apresentam a menor variância.

P

P

Prova. Seja ^ 1 = i di yi . Tomemos um outro estimador ~ 1 = i wi yi , o qual é linear e

não viesado. Para este ser não viesado, devemos observar que:

X

~ =

wi yi

1

i

=

X

i

=

0

wi (

X

0

+

wi +

1 xi

1

i

+ ui )

X

wi xi +

i

X

wi ui

i

Para que este outro estimador seja não viesado devemos ter que:

E ~1 =

25

1

E para ocorrer isso, devem valer as seguintes condições:

X

wi = 0

X

i

wi xi = 1

i

Para que o estimador possa ser escrito como:

X

~ =

+

wi ui

1

1

i

Como estamos supondo que X é não-estocástico, então:

!

X

X

X

E

E (wi ui ) =

wi E (ui ) = 0

wi ui =

i

i

i

visto que wi é função de xi , o qual é não-estocástico.

Analisando a variância de ~ 1 :

V ar ~ 1

= E

~

E ~1

= E

~

= E

X

1

2

2

1

1

2

wi ui

h

i

= E (w1 u1 + ::: + wn un )2

V ar ~ 1

= E w12 u21 + ::: + E wn2 u2n

X

2

wi2

=

Agora, vejamos qual o wi que gera a menor variância. Para isso:

X

min

wi2

wi

i

s:t:

X

wi = 0

([

1 ])

wi xi = 1

([

2 ])

i

X

i

L=

X

i

wi2

1

X

wi

i

2

X

i

26

wi xi

1

!

As CPOs serão:

@L

= 2wi

@wi

X

wi = 0

X

2 xi

1

= 0 =) 2wi =

1

+

2 xi

(3)

(4)

i

wi xi = 1

(5)

i

Passando o somatório na equação (3), temos:

X

X

2

wi =

1+

i

X

2

i

wi = n

+

1

2

i

X

X

xi

i

xi

i

Substituindo (4) acima, teremos:

0 = n

=

1

+

1

2

X

P

i xi

2

xi

i

n

=

2x

(6)

Substituindo wi de (3) em (5), teremos:

X

X(

wi xi =

| i {z }

i

1

1

2

1 =

2 =

1

|

+ 2 xi )

xi

2

{z

}

wi

1

X

xi +

i

1

X

xi +

2

i

Substituindo (6) em (7), teremos:

X

xi +

2x

2

i

2

x

X

xi +

i

2

2

X

X

xnx +

X

x2i

27

X

x2i

x2i

!

!

(7)

(8)

x2i = 2

x2i

X

2

X

!

= 2

x2i

= 2

nx2

= 2

(9)

Agora, relembre que:

X

X

(xi x)2 =

x2i

i

i

=

X

2xi x + x2 =

X

X

x2i

i

x2i

2

2xnx + nx

x2i

nx2

2x

X

i

xi +

X

x2

i

i

(xi

x)2 =

i

X

i

Então podemos substituir esta expressão em (9):

X

(xi x)2 = 2

2

i

2

Substituindo (10) em (6), temos:

1

2

i (xi

=P

=P

(10)

x)2

2x

i (xi

(11)

x)2

Substituindo (10) e (11) em (3), temos:

1

( 1 + 2 xi )

2

!

1

2x

2xi

+P

P

2

x)2

x)2

i (xi

i (xi

!

x

xi

+P

P

x)2

x)2

i (xi

i (xi

x x

= di

P

x)2

i (xi

wi =

wi =

wi =

wi =

P

Então, o próprio di gera a menor variância. Logo, ^ 1 = i di yi (EMQ) é o estimador

que possui menor variância, dentro da classe de estimadores lineares não-vieados.

4

Regressão Linear Múltipla (RLM)

Seja o seguinte modelo de regressão múltipla:

yi =

0

+

1 x1i

+

2 x2i

28

+ ::: +

k xki

+ ui ;