Inferencia Estadı́stica

J. Humberto Mayorga A.

Profesor Asociado

Departamento de Estadı́stica - Facultad de Ciencias

Universidad Nacional de Colombia

2

Índice General

Prólogo

iii

Introducción

v

1 DISTRIBUCIONES MUESTRALES

1.1 La Inferencia estadı́stica, un soporte epistemológico . . . . . . .

1.2 Preliminares en la Inferencia estadı́stica . . . . . . . . . . . . .

1.3 Preliminares en convergencia de variables aleatorias . . . . . .

1.4 Caracterı́sticas generales de algunas estadı́sticas . . . . . . . . .

1.5 Estadı́sticas de orden . . . . . . . . . . . . . . . . . . . . . . . .

1.5.1 Distribución de las estadı́sticas de orden . . . . . . . . .

1.5.2 Distribución del rango, semirango y mediana muestrales

1.5.3 Distribución de la función de distribución empı́rica . . .

1.6 Momentos de estadı́sticas de orden . . . . . . . . . . . . . . . .

1.7 Demostración de los teoremas del capı́tulo . . . . . . . . . . . .

1.8 Ejercicios del capı́tulo . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

1

1

4

9

12

18

19

20

21

23

25

42

2 ESTIMACIÓN PUNTUAL DE PARÁMETROS

49

2.1 Métodos clásicos para construir estimadores . . . . . . . . . . . . 51

2.1.1 El método de máxima verosimilitud . . . . . . . . . . . . 51

2.1.2 El método de los momentos . . . . . . . . . . . . . . . . . 61

2.1.3 El método por analogı́a . . . . . . . . . . . . . . . . . . . 64

2.1.4 Estimación Bayesiana . . . . . . . . . . . . . . . . . . . . 65

2.2 Criterios para examinar estimadores . . . . . . . . . . . . . . . . 69

2.2.1 Concentración, un requisito de precisión . . . . . . . . . . 69

2.2.2 Consistencia, un requisito ligado al tamaño de la muestra 73

2.2.3 Suficiencia, un requisito de retención de información . . . 75

2.2.4 Varianza mı́nima, un requisito de máxima precisión . . . 83

2.2.5 Completez, un requisito de la distribución muestral . . . . 90

2.2.6 Robustez, un requisito de estabilidad . . . . . . . . . . . . 96

2.3 Demostración de los teoremas del capı́tulo . . . . . . . . . . . . . 98

2.4 Ejercicios del capı́tulo . . . . . . . . . . . . . . . . . . . . . . . . 104

i

ii

ÍNDICE GENERAL

3 ESTIMACIÓN POR INTERVALO DE PARÁMETROS

115

3.1 Conceptos preliminares . . . . . . . . . . . . . . . . . . . . . . . . 116

3.2 El método de la variable pivote . . . . . . . . . . . . . . . . . . . 117

3.3 Estimación de promedios, bajo Normalidad . . . . . . . . . . . . 124

3.3.1 Intervalos confidenciales para el promedio de una población124

3.3.2 Estimación de la proporción poblacional . . . . . . . . . . 127

3.3.3 Intervalo confidencial para la diferencia de promedios basado una muestra pareada . . . . . . . . . . . . . . . . . . . 128

3.3.4 Intervalos confidenciales para la diferencia de promedios

en poblaciones independientes . . . . . . . . . . . . . . . . 129

3.4 Estimación de varianzas, bajo Normalidad . . . . . . . . . . . . . 131

3.4.1 Intervalos confidenciales para la varianza de una población 131

3.4.2 Intervalos confidenciales para el cociente de varianzas de

dos poblaciones independientes . . . . . . . . . . . . . . . 134

3.5 Ejemplos numéricos de aplicación . . . . . . . . . . . . . . . . . . 137

3.6 Tamaño de la muestra simple bajo Normalidad . . . . . . . . . . 139

3.7 Estimación Bayesiana por intervalo . . . . . . . . . . . . . . . . . 140

3.8 Demostración de los teoremas del capı́tulo . . . . . . . . . . . . . 142

3.9 Ejercicios del capı́tulo . . . . . . . . . . . . . . . . . . . . . . . . 144

4 JUZGAMIENTO DE HIPÓTESIS

4.1 Elementos básicos . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2 Tests más potentes . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3 Juzgamiento de hipótesis sobre promedios, bajo Normalidad . . .

4.3.1 Juzgamiento de la hipótesis nula H0 : μ = μ0 . . . . . . .

4.3.2 Juzgamiento de la hipótesis nula H0 : μ1 − μ2 = δ0 . . . .

4.4 Juzgamiento de hipótesis sobre varianzas, bajo Normalidad . . .

4.4.1 Juzgamiento de la hipótesis nula H0 : σ 2 = σ02 . . . . . . .

4.4.2 Juzgamiento de homoscedasticidad . . . . . . . . . . . . .

4.5 Juzgamiento de proporciones . . . . . . . . . . . . . . . . . . . .

4.6 Ejemplos numéricos de aplicación . . . . . . . . . . . . . . . . . .

4.7 Tamaño de la muestra . . . . . . . . . . . . . . . . . . . . . . . .

4.8 Juzgamiento secuencial . . . . . . . . . . . . . . . . . . . . . . . .

4.9 Juzgamiento del ajuste . . . . . . . . . . . . . . . . . . . . . . . .

4.9.1 Juzgamiento del ajuste por el método de Pearson . . . . .

4.9.2 Juzgamiento del ajuste por el método de KolmogorovSmirnov . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.10 Demostración de los teoremas del capı́tulo . . . . . . . . . . . . .

4.11 Ejercicios del capı́tulo . . . . . . . . . . . . . . . . . . . . . . . .

147

148

158

172

172

180

189

189

191

193

196

198

200

208

209

214

218

223

Prólogo

La escritura de este libro siempre estuvo animada por el deseo obstinado de

secundar el trabajo que realiza el estudiante tanto en el salón de clase como

fuera de él; pues entiendo que en definitiva es el estudiante quien aprehende los

conceptos como fruto de sus quehaceres académicos, conceptos inducidos más

por sus dudas, por sus dificultades y por algunas contradicciones con algunos de

sus preconceptos, que por alguna exposición frente al tablero. En mi criterio, el

profesor como acompañante en la formación profesional, se convierte solamente

en orientador, animador y crı́tico.

Con ese espı́ritu quise que este libro se constituyese en una juiciosa preparación de clase de la asignatura Inferencia Estadı́stica, preparación que ha

acopiado las memorias de cada una de las oportunidades en las cuales fui el

el encargado del curso a través de mis años como docente en la Universidad

Nacional de Colombia. De ese acopio es profuso lo desechado y lo corregido,

pues las preguntas de los estudiantes confundidos, las preguntas inteligentes y las

respuestas sobresalientes como las equivocadas en las evaluaciones, generalmente

sucitaron la reflexión sobre las formas y contenidos de los guiones de la clase.

No pretendo publicar un texto mas, pues los hay de una calidad inmejorable,

algunos clásicos cuya consulta es obligada, otros de reciente edición que han incorporado nuevos desarrollos conceptuales. Pretende el texto apoyar el trabajo

académico que se realiza en el curso, especialmente con el propósito de optimizar el tiempo y la calidad de la exposición de los temas, dando paso a la utilización del tablero acompañado de la tecnologı́a audiovisual como posibilidad

para profundizar algunos de los temas y como medio para tratar las preguntas e inquietudes estudiantiles y no como instrumento transcriptor de frases y

gráficas.

En este libro expreso mis apreciaciones personales semánticas y conceptuales

promovidas por la concepción que tengo sobre la Estadı́stica y particularmente

sobre la Inferencia estadı́stica, concepción que he madurado y he hecho propia,

a partir de las reflexiones con profesores del Departamento de Estadı́stica, a

partir de discusiones informales y dentro de eventos académicos. Su contenido

y organización responden a la forma tradicional como he realizado el curso, a

las limitaciones de un semestre académico para su desarrollo y a los requisitos

curriculares exigidos a los estudiantes que lo cursan.

Fue la circunstancia de mi año sabático, disfrutado durante el año 2002, la

que hizo posible la redacción y digitación de este texto, pues fueron múltiples

iii

iv

PRÓLOGO

las ocasiones fallidas de organizar en un libro el material de la clase, debido a

las ocupaciones derivadas de mis compromisos académicos, administrativos y de

servicios de asesorı́a estadı́stica que la Universidad me encargó llevar a cabo.

Finalmente, creó que debo agradecer tanto a mis alumnos pues ellos son el

motivo para organizar las ideas que presento entorno a la Inferencia estadı́stica,

como a la Universidad Nacional de Colombia que aceptó como plan de actividades de mi año sabático, la elaboración de este texto.

Introducción

Este texto ha sido concebido para ser fundamentalmente un texto guı́a en

el desarrollo de la asignatura Inferencia Estadı́stica, que cursan tanto los estudiantes del pregrado en Estadı́stica como los estudiantes de la Carrera de

Matemáticas. Puede apoyar igualmente algunos temas de la asignatura Estadı́stica Matemática de la Maestrı́a en Estadı́stica. El requisito natural e inmediato para abordar los temas de cada uno de los capı́tulos del libro, es un

curso de Probabilidad, y por supuesto los cursos de Cálculo. Consta de cuatro capı́tulos que pueden desarrollarse durante un semestre académico con seis

horas semanales de clase tradicional.

He adaptado traducciones de uso corriente en los textos de Estadı́stica a

formas y términos con un mejor manejo del idioma y que semánticamente correspondan con mayor fidelidad al concepto que denominan. Igualmente hago

precisión sobre algunas expresiones usuales para mayor claridad conceptual.

Cada capı́tulo está estructurado en tres partes: exposición de los temas,

demostraciones de los teoremas y la relación de los ejercicios correspondientes.

Esto no significa que el manejo del texto deba llevarse en el orden mencionado.

He querido organizarlo ası́, con el objeto de que la presentación de los temas

exhiba una forma continua y que las demostraciones y los ejercicios tengan su

sitio especial propio. Los ejercicios no están ordenados ni por su complejidad,

ni por el tema tratado, para no encasillarlos. El estudiante se acerca a un

ejercicio con información y trabajo previos, y es con su organización de ideas

y búsqueda de caminos que debe evaluar si con los elementos estudiados hasta

un cierto punto le es posible abordar el ejercicio particular; sin embargo, el

profesor puede sugerir la realización de alguno o algunos ejercicios cuando haya

culminado un tema o parte de él.

El primer capı́tulo como fundamento del texto, ubica sintéticamente a la

Inferencia Estadı́stica dentro del problema filosófico secular de la inducción.

Retoma el tema de la convergencia de sucesiones de variables aleatorias, y expone las ideas preliminares de la Inferencia Estadı́stica. El segundo capı́tulo

presenta los métodos corrientes de construcción de estimadores y los criterios

para examinar las estadı́sticas en su calidad de estimadores.

En el tercer capı́tulo se presenta el método de la variable pivote para construir intervalos confidenciales y se hace algún énfasis en los intervalos confidenciales bajo Normalidad. En el cuarto capı́tulo se adopta la expresión juzgamiento de hipótesis a cambio de prueba, docimasia o cotejo, porque esta acepción

v

vi

INTRODUCCIÓN

está más cerca del sentido de la toma de decisiones estadı́sticas e igualmente se

da un espacio importante en el juzgamiento de hipótesis bajo Normalidad.

Capı́tulo 1

DISTRIBUCIONES

MUESTRALES

“El conocimiento que tenemos del mundo está basado en la elaboración de un

modelo de la realidad, modelo que puede cotejarse con la experiencia tan sólo

de manera parcial y ocasionalmente... Este modelo se construye teniendo en

cuenta la utilización que hacemos del mismo...”

J. Bruner, “On cognitive growth”

Antes de entrar en materia, es preciso destinar unos pocos párrafos para

introducir un bosquejo del contexto en el cual la Inferencia estadı́stica puede

ubicarse, más como exposición de ideas generales que el pretender una disquisición filosófica al respecto. Ese contexto está contenido dentro de un problema

más general de carácter epistemológico, que el lector puede profundizar con las

copiosas publicaciones sobre el tema. Posteriormente, por tratarse de uno de

los fundamentos sobre el cual la Inferencia Estadı́sitica erige algunos de sus

conceptos, se incluye la sección 1.3 a manera de un extracto de la convergencia de sucesiones de variables aleatorias, tema integrante de un curso previo de

Probabilidad, pero que se retoma por su carácter y por su utilidad próxima.

1.1

La Inferencia estadı́stica, un soporte epistemológico

La inferencia inductiva, procedimiento que utiliza la lógica como una forma

de generalizar a partir de hechos particulares o a partir de la observación de

un número finito de casos, es uno de los temas que ha ocupado a filósofos y

cientı́ficos de todos los tiempos, desde la época de Aristóteles, tres siglos antes

de Cristo, hasta la actualidad.

1

2

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

Varios filósofos antiguos formados en el empirismo gnoseológico, convencidos

de que la observación era la única fuente segura de conocimiento, fueron los

primeros en proponer la inducción o inferencia inductiva como método lógico.

Tempranamente la inducción se convierte en un tema de mucha controversia que

aún se mantiene; si para Aristóteles, quien planteó inicialmente el procedimiento

inductivo, la Ciencia es “conocimiento demostrativo”, por el contrario para

Sexto Empı́rico, uno de los filósofos representantes del Escepticismo, la Ciencia

es “comprensión segura, cierta e inmutable fundada en la razón”. Ası́, mientras

Sexto Empı́rico rechaza la validez de la inducción, Filodemo de Gadara, filósofo

seguidor del Epicureı́smo, defiende la inducción como método pertinente.

Y la controversia, llamada el problema de la inducción o también conocida

como el “problema de Hume”, reside precisamente en que mientras la inferencia

deductiva avala la transferencia de la verdad de las premisas a la conclusión,

es decir, a partir de premisas verdaderas todas deducción es cierta, a costa de

no incorporar nada al contenido de las premisas, la inducción por su parte que

va más allá de las premisas, por su carácter amplificador, puede dar lugar a

conclusiones falsas; en pocas palabras la controversia se centra en la validez

que puedan tener los razonamientos inductivos, puesto que las conclusiones por

medio de la inducción no siempre serán verdaderas.

Algunos pensadores medievales también se preocuparon de la inducción. El

inglés Robert Grosseteste al utilizar para su trabajo cientı́fico los métodos aplicados por sus discı́pulos de Oxford en Óptica y Astronomı́a, reabre en la Edad

Media el tema de la inducción; si bien varios filósofos de la época orientaron

sus reflexiones hacia los métodos inductivos, los ensayos y trabajos de Francis

Bacon inspirados en la reorganización de las ciencias naturales, constituyeron el

apogeo del método inductivo.

No obstante, para Hume las leyes cientı́ficas no tienen carácter universal, es

decir son válidas únicamente cuando la experiencia ha mostrado su certidumbre

y tampoco tiene la función de la previsibilidad. Popper, filósofo de la Ciencia,

conocido por su teorı́a del método cientı́fico y por su crı́tica al determinismo

histórico, en el mismo sentido de Hume, afirma que no puede existir ningún

razonamiento válido a partir de enunciados singulares a leyes universales o a

teorı́as cientı́ficas. Mas recientemente, Bertrand Russell mantiene la posición de

Hume de la invalidez de la inducción, pero considera que ella es el camino para

incrementar la probabilidad, como grado racional de creencia, de las generalizaciones.

La conocida Ley débil de los grandes números incluida en la cuarta parte

del trabajo más sobresaliente de Jacob Bernoulli, Ars Conjectandi, publicado

después de su muerte en el año 1713, y el también conocido teorema de Bayes

publicado cincuenta años más tarde, trajeron nuevos elementos en la discusión al

constituirse en argumentos matemáticos que sustentan la posibilidad de inferir

probabilidades desconocidas a partir de frecuencias relativas. Sin embargo para

Popper, sustituir la exigencia de verdad por la validez probabilı́stica para las

inferencias inductivas no lo hace un procedimiento legı́timo.

Durante las primeras décadas del siglo pasado, a raı́z de los importantes

avances de la Ciencia ocurridos a finales del siglo XIX y a principios del siglo

1.1. LA INFERENCIA ESTADÍSTICA, UN SOPORTE EPISTEMOLÓGICO

3

XX, avances que no podı́an pasar desapercibidos para los pensadores, obligaron

a los filósofos a revisar muchas de las ideas de los clásicos y es ası́ como un grupo

de hombres de ciencia, matemáticos y filósofos, se organizan en 1922 en torno

al fı́sico Moritz Schlick, profesor de filosofı́a de la ciencia de la Universidad de

Viena, convirtiéndose en un movimiento filosófico internacional, principal promotor del positivismo lógico, (también llamado neopositivismo, neoempirismo

o empirismo lógico), movimiento conocido como Cı́rculo de Viena, conformado

entre otros, además de Schlick, por Hahn, Frank, Neurath, Kraft, Feigl, Waismann, Gödel, y Carnap; Einstein, Russell y Wittgenstein eran considerados

como miembros honorı́ficos y Ramsey y Reinchenbach como miembros simpatizantes del mismo.

Este movimiento filosófico se dedicó a muchos y variados temas de la Filosofı́a

de la Ciencia, y por supuesto al problema de la inducción. En sı́ntesis se puede

afirmar que el hilo conductor de las ideas del Cı́rculo de Viena fue la defensa

de una visión cientı́fica del mundo a través de una ciencia unificada ligado al

empleo del análisis lógico en el sentido de Russell.

Pero respecto al tema de la inducción, el Cı́rculo no cerró la discusión; concretamente para Popper y sus seguidores, la escuela del refutacionismo, el método

cientı́fico no utiliza razonamientos inductivos, sino razonamientos hipotéticodeductivos, ası́ se acopien datos y hechos particulares dentro del procedimiento

de evaluación de una hipótesis que dan paso a una conclusión de carácter general,

no existe como tal un razonamiento inductivo. Para el refutacionismo la ciencia

se concibe como una sucesión de conjeturas y refutaciones: se proponen conjeturas para explicar los hechos, que luego serán refutadas para promover nuevas

conjeturas. En sı́ntesis, para Popper y su escuela, ninguna teorı́a cientı́fica puede

establecerse en forma concluyente.

Sin embargo, para Feyerabend y Kuhn, en otro momento de gran controversia en este tema, las décadas del 60 y 70, la práctica cientı́fica no está en

correspondencia con este proceder racional ni tampoco puede lograrlo, porque

en gran medida existen supuestos relativos a la objetividad, a la verdad, al papel

de la evidencia y a la invariabilidad semántica. Para Feyerabend, no existen,

principios universables de racionalidad cientı́fica; el crecimiento del conocimiento es siempre especı́fico y diferente como tampoco sigue un camino de antemano

fijado.

Dentro de esta controversia, a la Inferencia estadı́stica no se le ha eximido

del problema de la inducción. Ronald Fisher, considerado por muchos el padre

de la Estadı́stica, defendió el papel inductivo que conlleva el juzgamiento de

hipótesis 1 . Sin embargo un sector de cientı́ficos y filósofos consideran que tanto

la estimación de parámetros como el juzgamiento de hipótesis tienen dirección

inductiva pero el razonamiento o inferencia que se lleva a cabo es de carácter

deductivo.

En fin, la Historia y la Filosofı́a de la Ciencia tuvieron un enorme auge a

lo largo del siglo pasado, continúan acopiando y estructurando reflexiones y

argumentos sobre la inducción, pero al no ser el propósito de esta sección tratar

1 La

denominación juzgamiento de hipótesis será justificada en el capı́tulo 4.

4

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

el proceso lógico de la inducción desde el punto de vista filosófico, ni tampoco

pretender su recuento histórico, ni mucho menos asumir una posición respecto

a ella, se omiten nombres de muy destacados pensadores contemporáneos. Lo

que realmente motiva incluir los párrafos anteriores es poner de manifiesto de

manera muy concisa el hecho de que el problema de la inducción es un problema

filosófico vigente con 23 siglos de existencia al cual generaciones de filósofos y

cientı́ficos se han dedicado.

Y más allá del debate epistemológico y metafı́sico contermporáneo dentro

de la Filosofı́a de la Ciencia, es cierto que gran parte de la Ciencia actual frente

a una naturaleza entrelazada de azar concomitante con una variabilidad inherente, reconoce de una u otra manera que el ensanche de su cuerpo conceptual

requiere de la participación impresindible de la Estadı́stica. Mucho antes de

la omnipresencia del computador, de los avances vertiginosos de la teorı́a y

métodos estadı́sticos de los últimos tiempos, Hempel en 1964 en su libro, Aspectos de la explicación cientı́fica, se referı́a a los dos modelos de explicación

de tipo estadı́stico:“el modelo estadı́stico deductivo, en el que las regularidades

estadı́sticas son deducidas de otras leyes estadı́sticas más amplias, y el modelo

estadı́stico inductivo, en el que los hechos singulares se explican subsumiéndolos

bajo leyes estadı́sticas”.

En esta dirección cuando en los quehaceres cientı́ficos, tecnológicos o administrativos se recurre a la Estadı́stica para organizar y orientar sus procesos

y métodos, como de igual manera cuando se recurre a ella para apoyar argumentos y decisiones, ese recurso suele convertirse, desde uno de los puntos de

vista, en un proceso de inducción especı́ficamente en un proceso que puede ser

clasificado como de inducción amplificadora, de manera análoga a como Francis

Bacon vio en la inducción el procedimiento escencial del método experimental,

o convertirse en una serie de actividades ligadas a un procedimiento propio de

la ciencia o la tecnologı́a , en un procedimiento hipotético-deductivo, como lo

entiende la escuela propperiana. Para cualquiera de los dos puntos de vista que

se asuma, la Estadı́stica brinda un respaldo exclusivo en la inferencia.

1.2

Preliminares en la Inferencia estadı́stica

Dentro del contexto del parágrafo anterior, cabe formularse varias preguntas;

la primera de ellas: ¿Cuál es el objeto para el cual son válidos los enunciados

generales producto de la inducción, de la decisión o la estimación que realiza una

aplicación estadı́stica?. Paralelamente tiene lugar la segunda pregunta: ¿Cuáles

son las unidades que permiten obtener la información de casos particulares como

punto inicial en el citado proceso?. Y la tercera pregunta, que interroga sobre

la calidad del proceso de inferencia estadı́stica: ¿Cuáles son los principios que

rigen este proceso tan particular de inferencia?.

La primera pregunta indaga por el conjunto de todos los elementos que

en un determinado momento son del interés de un investigador, de un gestor

o de un tomador de decisiones. Elementos que son diferentes entre sı́ pero

que tienen una o varias caracterı́sticas comunes que los hacen miembros del

1.2. PRELIMINARES EN LA INFERENCIA ESTADÍSTICA

5

conjunto en consideración. Al respecto en algunas disciplinas cientı́ficas esas

caracterı́sticas comunes son denominadas criterios de inclusión, complementados

con los criterios de exclusión, para definir concisamente la pertenencia de un

elemento al conjunto y para precisar igualmente la pérdida de la calidad de

pertenencia del elemento.

Para referirse a ese conjunto mencionado anteriormente el lenguaje corriente

de la Estadı́stica utiliza el término población; ese agregado o colección de las

unidades de interés es en últimas el objeto receptor del producto del proceso de

inducción, de la decisión o de la estimación.

La segunda pregunta parece confundirse con la primera. Si bien es cierto que la pregunta se refiere a esas entidades que corresponden a los hechos

particulares, a los casos singulares, a ese conjunto finito de casos, que son

examinados durante la primera etapa de la inferencia, la reunión de todas las

unidades posibles, constituye ese conjunto que se ha llamado población. Pero su

estricta determinación radica en que cada una de esas unidades será, en sentido

metafórico, un interlocutor con el investigador. Interlocutor, porque la investigación puede entenderse, de manera análoga, como un proceso comunicativo:

el investigador pregunta, la naturaleza responde. Esas unidades pueden ser denotadas como unidades estadı́sticas, de manera genérica para subsumir en

esa denominación, otras como unidad experimental, unidad de análisis, sujeto,

caso, entre otras.

Como en casi todas las oportunidades, de hecho no existe la posibilidad de

“dialogar”con todas y cada una de las unidades estadı́sticas, debido a imperativos que lo impiden, asociados a varios aspectos. Por ejemplo, cuando el tamaño

de la población, es decir, el cardinal del conjunto que reúne a todas las unidades

estadı́sticas, es ingente; o también cuando la respuesta de la unidad implica

su desnaturalización o deterioro; igualmente cuando ese “diálogo”es oneroso, o

cuando los resultados de la investigación se requieren con apremio.

A ese subconjunto de unidades que un párrafo anterior se referı́a como el

conjunto finito de casos que son examinados durante la primera etapa del proceso de inferencia, circunscrito al subconjunto de unidades estadı́sticas elegidas

por medio de procedimientos estadı́sticos formales, por supuesto, se le designa

corrientemente como muestra.

A diferencia de las dos preguntas anteriores, cuyas respuestas son en últimas

acuerdos semánticos, la tercera es una pregunta fundamental que requiere

respuestas a partir de elaboraciones conceptuales, repuestas que se darán

gradualmente con el desarrollo de los capı́tulos objeto de este texto; pero previamente de una manera sucinta se esboza el fundamento de las respuestas.

La Estadı́stica facultada para sustentar y conducir procesos de inducción, decisión y estimación muy caracterı́sticos, cuenta con la inferencia estadı́stica como

la fuente conceptual que nutre, avala y licencia la estructura y funcionamiento

de métodos y procedimientos estadı́sticos. Para el desarrollo de cada una de

sus dos componentes, relativos a la estimación de parámetros y el juzgamiento

de hipótesis, la inferencia estadı́stica tiene como punto de partida la referencia o el establecimiento de modelos para representar variables observables o no

observables, modelos que pueden ser explı́citos o generales.

6

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

Semánticamente el vocablo modelo responde a varias acepciones, particularmente dentro del lenguaje cientı́fico y tecnológico. Sin embargo el sentido

que la Estadı́stica le confiere al término, es el de consistir en una traducción

de un aspecto de la realidad a un lenguaje simbólico, como uno de los recursos

para representar de manera simplificada su comportamiento, que habilite procesos de generalización, que incluya sus aspectos fundamentales, que facilite su

descripción o permita la toma de decisiones.

La factibilidad de representar variables muy disı́miles asociadas con fenómenos de distintos campos del saber a través de un mismo modelo de probabilidad,

permite a la Inferencia estadı́stica detenerse en el modelo mismo para convertirlo en su objeto de estudio. A partir de su estructura, de las expresiones

matemáticas asociada a su naturaleza y con ellas de la presencia y papel que

desempeñan los parámetros, se construyen y evalúan posibles estimadores de estos últimos, y de igual manera se derivan y evalúan procedimientos que permitan

juzgar afirmaciones sobre el modelo.

En consecuencia, los principios que avalan procesos de carácter estadı́stico,

tratados por la Inferencia estadı́stica y motivo de la tercera pregunta, consisten

en métodos y criterios relacionados tanto con la construcción de estimadores y

test como con el examen de la aptitud e idoneidad de los mismos, y que tal

como se anunció, la descripción y el desarrollo de los citados principios son en

definitiva el contenido mismo de este texto.

Definición 1.2.1. Una muestra aleatoria es una sucesión finita de

variables aleatorias independientes e idénticamente distribuidas X1 , X2 , . . . , Xn .

De manera más general una sucesión de variables aleatorias X1 , X2 , . . . , independientes y con idéntica distribución, también se denomina muestra aleatoria.

En el caso de una sucesión finita, el valor n recibe el nombre de tamaño de la

muestra o tamaño muestral.

La definción anterior revela que en el contexto estadı́stico el término muestra

presenta dos acepciones: la de ser un subconjunto de unidades estadı́sticas elegidas por métodos estadı́sticos formales y la adjetivada como aleatoria expuesta

en la definición anterior, ésta referida a una sucesión de variables aleatorias. Lo

mismo le ocurre al término población: denota al conjunto completo de unidades

estadı́sticas objeto de estudio y ahora se le concibe como una variable aleatoria,

en el sentido que se expone seguidamente.

El acceso al estudio de ese conjunto de unidades estadı́sticas, se lleva a

cabo mediante el examen de las caracterı́sticas o respuestas de sus integrantes,

interpretadas como variables; el discernimiento de la esencia ya no individual

sino colectiva de las unidades es en suma el motivo de la investigación o estudio;

por ello el comportamiento de las variables se convierte entonces en un elemento

revelador de caracterı́sticas y propiedades que sustentan la descripción de la

colectividad, las explicaciones o las decisiones a que haya lugar.

El comportamiento real de una o varias variables es un comportamiento reflejo de la naturaleza de la población, que no siempre es posible conocer. Por ello

acudir a modelos de probabilidad para emular el comportamiento poblacional

es un recurso legı́timo que reduce carencias, permite aprovechar las virtudes

1.2. PRELIMINARES EN LA INFERENCIA ESTADÍSTICA

7

propias del modelo y hace posible la utilización de un lenguaje universal, por

supuesto sobre la base de una escogencia juiciosa del modelo.

Entonces, un aspecto de las unidades estadı́sticas observado, medido o cuantificado en una variable, (o varios aspectos utilizando un vector para disponer

las variables) se le abstrae como una variable aleatoria (o un vector aleatorio)

que tiene asociado un modelo particular. Esta variable aleatoria que representa

una variable en la población suele denominársele igualmente población.

Bajo estas consideraciones la sucesión de variables aleatorias X1 , X2 , . . . , Xn ,

de la definición anterior denominada muestra aleatoria además de ser un elemento del ámbito conceptual de la Teorı́a Estadı́stica, puede vincularse con la

información especı́fica acopiada de un subconjunto de n unidades estadı́sticas

de las cuales se dispone de los valores x1 , x2 , . . . , xn , correspondientes a una

variable denotada por X. Dicho en otros términos el valor xi puede entenderse

como una realización de la correspondiente variable aleatoria Xi , i = 1, 2, . . . , n,

por eso es habitual encontrar recurrentemente la expresión “sea X1 , X2 , . . . , Xn

una muestra aleatoria de una población con función de densidad...”. El contexto

en el cual se encuentre el vocablo población, delimita la acepción en uso: un

conjunto o una variable aleatoria.

Definición 1.2.2. Se denomina Estadı́stica a una variable aleatoria

construida como una función de las variables aleatorias X1 , X2 , . . . , Xn que

conforman una muestra aleatoria, función que no depende de parámetro alguno constitutivo de la expresión algebraica que identifica al modelo asumido

para representar una variable en la población, ni tampoco depende de constantes

desconocidas, también llamados parámetros, que cuantifican rasgos generales en

la población cuando no se asume un modelo especı́fico.

Como el aspecto determinante en la naturaleza de una estadı́stica es su

no dependencia funcional de parámetros, se le resalta por medio del siguiente

ejemplo.

Ejemplo 1.2.1. Asumiendo el modelo Gaussiano para representar una variable

en la población, y si X1 , X2 , . . . , Xn es una muestra aleatoria de la población

ası́ modelada, son estadı́sticas entre otras

•

X1 + X2 + · · · + Xn

= Xn

n

•

(X1 − X n )2 + (X2 − X n )2 + · · · + (Xn − X n )2

= Sn2

n−1

• X1,n = min{X1 , X2 , . . . , Xn }

Puesto que los parámetros μ y σ son las constantes caracterı́sticas del

modelo Gaussiano, particularmente las dos siguientes variables aleatorias no

son estadı́sticas

n

2

(Xi − μ)2

n Xi − X n

i=1

σ

n−1

i=1

8

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

El contenido semántico que se les da en Estadı́stica tanto al término estimar

como al término estimación, para referirse a su acción o efecto, proviene de

una de las acepciones corrientes que tiene el segundo vocablo. El significado en

mención de: aprecio o valor que se da y en que se tasa o considera algo 2 , no

sugiere un cálculo aproximado de un valor como equivocadamente se entiende,

porque no hay referentes para calificar su aproximación, ni tampoco como un

proceso adivinatorio; debe entenderse como la realización formal de un avalúo,

es decir en llevar a cabo un proceso que exige de manera imprescindible el

contar con información de ese algo del cual se quiere fijar su valor. Por lo

tanto la calidad de la estimación, depende directamente de la calidad original

y la cantidad de información que se posea. Consecuentemente una cantidad

insuficiente de información genera estimaciones no fiables, como igualmente las

genera una gran cantidad de información de calidad exigua.

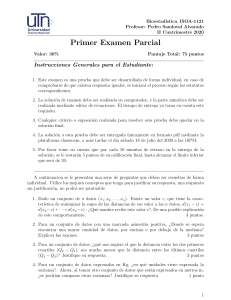

A manera de sinopsis, considerando simultáneamente tanto la cantidad de

información como su calidad y utilizando el plano cartesiano para su representación, en la siguiente figura se adjetivan distintas circunstancias en calidad

y cantidad de información que constituye el insumo en el proceso de estimación.

100%

Desechable

ADMISIBLE

Cantidad

Ideal

Funesta

0

Inadmisible

Calidad

100%

Figura 1.1: Diagrama de calidad y cantidad de información

La calidad de la información, de la cual este texto no se ocupa porque se pretenden propósitos de otro tipo, debe asegurarse a partir del diseño, construcción

y calibración de instrumentos para el registro de la información, dentro de la

organización y ejecución de las actividades de acopio de información y durante

2 Diccionario de la Lengua Española. Real Academia Española. Vigésimasegunda edición.2001

1.3. PRELIMINARES EN CONVERGENCIA DE VARIABLES ALEATORIAS

9

el proceso de almacenamiento y guarda de la información.

Definición 1.2.3. Una estadı́stica cuyas realizaciones son utilizadas para llevar

a cabo estimaciones de los parámetros de un modelo probabilı́stico se denomina

estimador y a las citadas realizaciones o valores particulares se les conoce como

estimaciones.

Definición 1.2.4. El modelo probabilı́stico que rige el comportamiento de una

estadı́stica o de un estimador se denomina distribución muestral de la

respectiva estadı́stica o del respectivo estimador.

Algunos autores se refieren a la distribución de la variable aleatoria que representa a la población, como la distribución original de las observaciones, o

modelo original y a la distribución muestral de una estadı́stica como la distribución reducida o modelo reducido.

Definición 1.2.5. Sea X1 , X2 , . . . , Xn una muestra aleatoria de una población

con momentos oridinarios y centrales μr y μr respectivamente. Los momentos

muestrales, ordinarios y centrales de orden r, r = 1, 2, . . . , cumplen en la

muestra funciones análogas a los momentos poblacionales μr y μr , y se denotan

y definen como

=

Mr,n

1 r

X

n i=1 i

Mr,n =

1

(Xi − X n )r

n i=1

n

n

En particular cuando r = 1, primer momento ordinario muestral, M1,n

= X n,

es llamado de manera más corriente, promedio muestral o promedio de la

muestra. Se prefiere como varianza muestral en cambio del segundo momento muestral, por razones que posteriormente se justificarán, a la expresión

1 (Xi − X n )2

n − 1 i=1

n

1.3

Preliminares en convergencia de variables

aleatorias

Para aprestar los elementos que se requieren en el tema de Inferencia estadı́stica,

es preciso abordar de una manera suscinta los tipos de convergencia de variables

aleatorias en razón a que posteriormente el crecimiento del tamaño de muestra

permite derivar propiedades interesantes de algunas estadı́sticas, y por lo tanto

el propósito de esta sección es presentar los tipos más corrientes de convergencia

de variables aleatorias.

Por medio de {Xn }, n = 1, 2, . . . , se describe una sucesión de variables

aleatorias X1 , X2 , . . . , la cual es una sucesión de funciones medibles {Xn (w)}

10

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

definida en un espacio muestral Ω, y teniendo en cuenta que todas las variables

aleatorias constituyentes de la sucesión están consideradas en el mismo espacio

de probabilidad (Ω, A, P ).

En primer lugar, siendo {Xn } una sucesión de variables aleatorias y c un

número real, el conjunto {w|Xn (w) = c} ∈ A, de tal manera que

P lim Xn = c = 1

n→∞

esté siempre definido.

Se dice que la sucesión de variables aleatorias {Xn } converge casi seguro

a cero o converge a cero con probabilidad uno si:

P lim Xn = 0 = 1

n→∞

Además, si las variables aleatorias X1 , X2 , . . . , y la variable aleatoria particular

X están definidas en el mismo espacio de probabilidad, se afirma que la sucesión

de variables aleatorias {Xn } converge casi seguro a la variable aleatoria

X, si la sucesión de variables aleatorias {Xn − X} converge casi seguro a cero,

este tipo de convergencia también se conoce como convergencia fuerte y se

simboliza como

a.s.

Xn −−→ X

Ejemplo 1.3.1. Si el comportamiento probabilı́stico de cada una de las

variables aleatorias de la sucesión {Xn } se modela por medio de la distribución de Bernoulli de manera que Xn ∼ Ber(( 12 )n ), entonces

a.s.

Xn −−→ 0

En efecto,

P

lim Xn = 0 = 1

n→∞

n

n

n

1 − 12

, puede

puesto que P [Xn = 0] = 1 − 2 . Como V [Xn ] = 12

notarse el decrecimiento de la varianza en cuanto n se incrementa, es decir

que Xn va perdiendo el carácter de variable aleatoria porque su varianza va

tendiendo a cero, la variable va asumiendo rasgos de una constante.

1

En segundo lugar, se dice que la sucesión de variables aleatorias {Xn } converge en probabilidad a la variable aleatoria X, hecho simbolizado como,

p

→X

Xn −

si lim P [|Xn − X| < ] = 1, para > 0. Para referirse a la convergencia en

n→∞

probabilidad también puede utilizarse convergencia estocástica, convergencia en

medida o convergencia débil .

1.3. PRELIMINARES EN CONVERGENCIA DE VARIABLES ALEATORIAS

11

Un tercer tipo de convergencia se conoce como convergencia en momento

de orden r . En este caso cada variable de la sucesión de variables aleatorias

{Xn } y X poseen el momento ordinario de orden r. En estas circunstancias

se afirma que la sucesión de variables aleatorias converge en momento de

orden r a la variable aleatoria X, lo cual se representa como,

L

r

X

Xn −→

si lim E [(|Xn − X|)r ] = 0. Particularmente, si r = 1 suele decirse que la sucen→∞

sión de variables aleatorias {Xn } converge en valor esperado a la variable

aleatoria X. Similarmente, cuando r = 2 la convergencia se conoce como

convergencia en media cuadrática.

Un cuarto y último tipo de convergencia de variables aleatorias se refiere

a una sucesión de variables aleatorias {Xn }, cuya correspondiente sucesión de

funciones de distribución F1 (x), F2 (x), . . . , es considerada. De esta manera la

sucesión de variables aleatorias {Xn } converge en distribución a la variable

aleatoria X, cuya función de distribución es F (x), hecho denotado:

d

→X

Xn −

si lim Fn (x) = F (x) para todo x.

n→∞

Entre los diferentes tipos de convergencia existen relaciones que es necesario

destacar. El siguiente teorema las reúne.

Teorema 1.3.1. Estando las variables aleatorias X1 , X2 , . . . y la variable particular X difinidas sobre el mismo espacio de probabilidad (Ω, A, P ),

1. Si {Xn } converge casi seguro a la variable aleatoria X con probabilidad 1,

implica que {Xn } converge en probabilidad a la variable aleatoria X.

2. Si {Xn } converge en valor esperado a la variable aleatoria X, implica que

{Xn } convergen en probabilidad a la variable aleatoria X.

3. Si {Xn } converge en probabilidad a la variable aleatoria X implica que

{Xn } converge en distribución a la variable aleatoria X.

4. Siendo r > s, la convergencia de una sucesión de variables aleatorias

{Xn } en momento de orden r implica la convergencia de la sucesión en

momento de orden s.

De manera gráfica las relaciones que enuncia el teorema 1.3.1, se pueden

recapitular en la figura 1.2

Teorema 1.3.2 (Teorema de Lévy). Considerando la variable aleatoria particular X y la sucesión de variables aleatorias {Xn }, definidas sobre el mismo

espacio de probabilidad, y siendo {φn (t)} la sucesión de funciones caracterı́sticas

correspondientes a las variables de la sucesión {Xn },

d

→ X si y sólo si lim φn (t) = φ(t)

Xn −

n→∞

12

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

Convergencia

casi segura

Convergencia en

probabilidad

Convergencia en

distribución

Convergencia en

valor esperado

Figura 1.2: Relaciones entre algunos tipos de convergencia de variables aleatorias

para t ∈ R y φ(t) función caracterı́stica de la variable aleatoria X, continua en

cero.

Teorema 1.3.3 (Teorema de Lévy). - Versión para funciones generatrices de momentos - Considerando la variable aleatoria particular X y

la sucesión de variables aleatorias {Xn }, definidas sobre el mismo espacio de

probabilidad, y siendo {Mn (t)} la sucesión de funciones generatrices de momentos correspondientes a las variables de la sucesión {Xn }, las cuales existen para

t real en algún intervalo alrededor de cero,

d

→ X si y sólo si lim Mn (t) = M (t)

Xn −

n→∞

para t real en algún intervalo alrededor de cero y M (t) función generatriz de

momentos de la variable aleatoria X.

Teorema 1.3.4. Sea {Xn } una sucesión de variables aleatorias.

p

→ c si y sólo si lim Fn (x) = F (x)

Xn −

n→∞

siendo c una constante, Fn (x) la función de distribución de Xn y F (x) una

función de distribución tal que F (x) = 0 para x < c y F (x) = 1 para x ≥ c.

1.4

Caracterı́sticas generales de algunas estadı́sticas

Los momentos muestrales, además de cumplir funciones análogas a los momentos poblacionales como se incorporó en la definición 1.2.5, son estadı́sticas de

1.4. CARACTERÍSTICAS GENERALES DE ALGUNAS ESTADÍSTICAS

13

uso frencuente que bajo la garantı́a de la existencia de determinados momentos poblacionales, sus distribuciones muestrales poseen propiedades generales

respecto a su posición y a su dispersión en la forma como el siguiente teorema

lo indica.

Teorema 1.4.1. Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población

representada por la variable aleatoria X con varianza σ 2 y con momento ordinario μ2r , r = 1, 2, . . . , entonces el valor esperado y la varianza del momento

muestral ordinario son respectivamente:

E[Mr,n

] = μr

1

E[X 2r ] − (E[X r ])2

n

1 μ − (μr )2

=

n 2r

V [Mr,n

]=

Corolario 1.4.1.1. Bajo las hipótesis del teorema 1.4.1,

E[X n ] = μ1 = μ

V [X n ] =

σ2

n

Teorema 1.4.2. Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población

con valor esperado, también llamado promedio poblacional, μ y varianza σ 2 ,

y existiendo además el momento central de orden cuatro μ4 , entonces

1 (Xi − X n )2 = σ 2

n − 1 i=1

n

E[Sn2 ] = E

V

[Sn2 ]

1

=

n

n−3 4

σ ,n > 1

μ4 −

n−1

El tamaño de la muestra es un elemento substancial tanto para las disquisiciones en la teorı́a de la estadı́stica como para la utilización de la misma. La

pregunta por su magnitud es quizá de las más inquietantes para el investigador

en la búsqueda de respaldo a la confiabilidad de su investigación; el tamaño

muestral es uno de los aspectos con los cuales se certifican o descalifican estudios, es en definitiva un punto obligado para dilucidar.

La incidencia relevante del tamaño de la muestra en la distribución muestral

de muchas estadı́sticas, gira alrededor del tema conocido como distribuciones

asintóticas. En particular en la medida que se vaya incrementando el tamaño de

la muestra, el promedio muestral adquiere unos rasgos propios que los siguientes

teoremas describen.

14

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

Teorema 1.4.3 (Ley débil de los grandes números). Si X1 , X2 , . . . , Xn

es una muestra aleatoria de una población con valor esperado μ y varianza σ 2 ,

entonces

X1 + X2 + . . . + Xn p

−

→μ

n

La nota de la demostración del teorema anterior, destaca el hecho de que

P − < X n − μ < ≥ 1 − δ

σ2

para n entero mayor que 2 , > 0, δ > 0; lo cual permite determinar la

δ

magnitud del tamaño muestral bajo prefijados requisitos. Esta cota para el

tamaño de la muestra debe entenderse dentro del contexto de una población

infinita y una muestra simple.

Ejemplo 1.4.1. ¿Cuál debe ser el tamaño de la muestra para tener una

probabilidad de 0.95 de que el promedio muestral no difiera en más de una

cuarta parte de la desviación estándar de μ?

En esta situación, = 0.25σ, δ = 0.05, por lo tanto

n>

σ2

= 320

(0.25σ)2 0.05

Modificando parcialmente las condiciones del teorema 1.4.3 en el sentido de

no hacer ninguna mención de la varianza σ 2 , es posible reiterar la convergencia en probabilidad del promedio de la muestra, como lo presenta el siguiente

teorema.

Teorema 1.4.4 (Teorema de Khintchine). Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población con valor esperado μ entonces

p

Xn −

→μ

De manera más general, la convergencia en probabilidad de los momentos

muestrales ordinarios a los momentos poblacionales ordinarios está avalada por

el siguiente teorema.

Teorema 1.4.5. Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población

para la cual el momento central μ2r existe, entonces

p

Mr,n

−

→ μr ,

r = 1, 2, . . .

Para cerrar esta relación de teoremas que giran alrededor de la idea de la

Ley débil de los grandes números, se incluye el siguiente teorema que puede

entenderse como una generalización de la citada ley.

1.4. CARACTERÍSTICAS GENERALES DE ALGUNAS ESTADÍSTICAS

15

Teorema 1.4.6. Si X1 , X2 , . . . es una sucesión de variables aleatorias tales que

E[Xi ] = μi y V [Xi ] = σi2 son finitos y ρ(Xi , Xj ) = 0, i = j, para i = 1, 2, . . . ,

entonces

p

X n − μn −

→0

siendo μn =

n

1 μi

n i=1

La Ley fuerte de los grandes números es un conjunto de teoremas referentes

a la convergencia casi segura de sucesiones de variables aleatorias. El teorema siguiente es el más divulgado de todos y fue enunciado originalmente por

Kolmogorov.

Teorema 1.4.7 (Ley fuerte de los grandes números). Si X1 , X2 , . . . , Xn

es una muestra aleatoria de una población con valor esperado μ, entonces la

sucesión {X n − μ} converge casi seguro a cero.

Teorema 1.4.8. Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población

con valor esperado μ y varianza σ 2 , entonces

a.s.

Sn2 −−→ σ 2

p

y en consecuencia Sn2 −

→ σ2

Con la denominación de Teorema del Lı́mite Central debe entenderse más a

un conjunto de teoremas concernientes a la convergencia en distribución de la

suma de un número creciente de variables aleatorias al modelo Gaussiano, que a

la más popular de sus versiones. Es un conjunto de teoremas fundamentales de

la Estadı́stica pues constituyen puntos de apoyo substanciales de la Inferencia

estadı́stica y de las aplicaciones.

Bajo la citada denominación de teorema del lı́mite central se incluyen

variantes como la versión original conocida como la ley de los errores, derivada

de los trabajos de Gauss y Laplace sobre la teorı́a de errores, que permitió el

surgimiento de las versiones más antiguas referentes a variables con distribución

de Bernoulli, debidas a De Moivre y Laplace en los siglos XVI y XVII, se incluyen las versiones de Lindeberg-Lévy y Lindeberg-Feller, que son consecuencia

de un trabajo inciado por Chevyshev y Liapunov a finales del siglo XIX, trabajo

encaminado a la búsqueda de una demostración rigurosa, se incluyen las versiones de Bikelis y aquellas adaptadas para los casos multivariados, y también

se incluyen aquellas para el caso de variables dependientes.

En particular la versión clásica o Teorema de Lindeberg-Lévy, la versión más

difundida, corresponde al siguiente teorema, resultado al que llegaron de manera

independiente J.W.Lindeberg y P.Lévy en la segunda década del siglo XX.

Teorema 1.4.9 (Teorema del Lı́mite Central (Lindeberg-Lévy)). Si

X1 , X2 , . . . , Xn es una muestra aleatoria de una población con valor esperado

μ y varianza σ 2 finitos, considerando la variable aleatoria

Zn =

Xn − μ

√σ

n

16

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

entonces la sucesión de variables aleatorias {Zn } converge en distribución a una

variable aleatoria con distribución Normal estándar.

En pocas palabras, esta difundida versión determina que,

√

n(X n − μ) d

−

→ Z ∼ N (0, 1)

σ

El teorema del lı́mite central es la mejor justificación de la existencia del

modelo Gaussiano y del énfasis que de él se hace reiteradamente. Por otra

parte lo admirable del teorema radica en que no importa el modelo regente del

comportamiento probabilı́stico de la población, y en que la exigencia de finitud

del valor esperado y la varianza es fácil satisfacerla en las aplicaciones.

Para finalizar estas consideraciones acerca del teorema del lı́mite central se

presenta una versión especial la cual corresponde al teorema de Lindeberg-Feller.

Teorema 1.4.10 (Teorema del Lı́mite Central (Lindeberg-Feller)). Si

X1 , X2 , . . . es una sucesión de variables aleatorias independientes con valor esn

σi2 → ∞

perado μi y varianza σi2 finitos, i = 1, 2, . . . y asumiendo que τn2 =

i=1

2

σ

y además que max τ i2 → 0 cuando n → ∞, entonces

1≤i≤n

n

n

(Xi − μi )

i=1

τn

d

−

→ Z ∼ N (0, 1)

si y sólo si para cada > 0,

n

1 lim 2

(x − μi )2 fi (x)dx = 0

n→∞ τn

|x−μ

|≥τ

i

n

i=1

siendo fi (x) la función de densidad de la variable aleatoria Xi , i = 1, 2, . . .

Cuando el comportamiento de una población se asume regido por el

modelo Gaussiano, se pueden deducir propiedades especı́ficas adicionales para el

promedio y varianza muestrales, propiedades que hacen explı́citas los siguientes

teoremas.

Teorema 1.4.11. Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población

con distribución Normal de valor esperado μ y varianza σ 2 , entonces

σ2

X n ∼ N μ,

n

Teorema 1.4.12. Si X1 , X2 , . . . , Xn es una sucesión de variables aleatorias

independientes tales que Xi ∼ N (μi , σi2 ), entonces

2

n Xi − μi

∼ χ2 (n)

U=

σ

i

i=1

1.4. CARACTERÍSTICAS GENERALES DE ALGUNAS ESTADÍSTICAS

17

Corolario 1.4.12.1. Cuando la sucesión de variables aleatorias constituye una

muestra aleatoria de una población con distribución Normal, de valor esperado

μ y varianza σ 2 ,

U=

2

n Xi − μ

σ

i=1

∼ χ2 (n)

Teorema 1.4.13. Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población

con distribución Normal de valor esperado μ y varianza σ 2 , entonces las estadı́sticas X n y Sn2 son dos variables aleatorias estadı́sticamente independientes.

Teorema 1.4.14. Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población

Normal de valor esperado μ y varianza σ 2 , entonces

n

(Xi − X n )2

i=1

σ2

=

(n − 1)Sn2

∼ χ2 (n − 1)

σ2

Con supuestos menos taxativos, el promedio y la varianza muestrales presentan un comportamiento muy particular. Los siguientes teoremas resaltan la

marcada autonomı́a de las estadı́sticas X n y Sn2 .

Teorema 1.4.15. Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población

cuya función de densidad es simétrica, entonces

cov(X n , Sn2 ) = 0

La expresión usual de la varianza muestral incluye el promedio de la muestra,

es decir que la varianza podrı́a entenderse como función de éste. Sin embargo, su

presencia en la expresión puede considerarse aparente puesto que la varianza de

la muestra puede prescindir del promedio muestral en la forma como lo garantiza

el siguiente teorema 3 .

Teorema 1.4.16. Si X1 , X2 , . . . , Xn es una muestra aleatoria de una población

para la cual no se asume un modelo de probabilidad especı́fico, entonces

1

(Xi − Xj )2

2n(n − 1) i=1 j=1

n

Sn2 =

n

En sı́ntesis, es claro que el promedio y varianza de la muestra son estadı́sticas

tales que bajo el modelo Gaussiano son estadı́sticamente independientes, bajo un

modelo de probabilidad cuya función de densidad es simétrica, las estadı́sticas

no están correlacionadas, y en cualquier situación la varianza de la muestra no

depende funcionalmente del promedio de la muestra.

3 Jorge

E. Ortiz P. Boletı́n de Matemáticas. Volúmen VI No. 1 (1999), pp. 43-51

18

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

1.5

Estadı́sticas de orden

Una modalidad especial de estadı́sticas la integran las llamadas estadı́sticas

de orden. Ellas desempeñan papeles importantes en algunas aplicaciones como

en las Cartas de Control Estadı́stico de la Calidad y como en el fundamento y

manejo de algunos conceptos en Estadı́stica no paramétrica. Además de estos y

otros usos, las estadı́sticas de orden son particularmente los estimadores apropiados de parámetros que rigen el recorrido de la población, y ası́ mismo son

utilizadas en el juzgamiento de hipótesis referentes a estos parámetros. Por ser

estimadores y sustentar reglas de decisión en poblaciones especiales es menester

exponer algunos elementos y consideraciones acerca de su distribución.

Definición 1.5.1. La k-ésima estadı́stica de orden, k = 1, 2, . . . , n,

correspondiente a una muestra aleatoria X1 , X2 , . . . , Xn , denotada por Xk,n ,

está definida de la siguiente manera

Xk,n = min {{X1 , X2 , . . . , Xn } − {X1,n , X2,n , . . . , Xk−1,n }}

siendo

X1,n : mı́nimo de la muestra

Xn,n : máximo de la muestra

Al conjunto de estadı́sticas de orden X1,n , X2,n , . . . , Xn,n se le designa con el

nombre de muestra aleatoria ordenada.

A partir de las estadı́sticas de orden pueden definirse otras estadı́sticas como:

• El rango muestral

R = Xn,n − X1,n

• El semirango muestral

SR =

X1,n + Xn,n

2

• La mediana muestral

⎧

X n+1 ,n

, si n es impar

⎪

⎪

2

⎪

⎨

Me =

⎪

⎪

X n + X n2 +1,n

⎪

⎩ 2 ,n

, si n es par

2

• La función de distribución empı́rica o función de distribución

muestral

1

Fn (x) =

I(−∞,x] (xi )

n i=1

n

19

1.5. ESTADÍSTICAS DE ORDEN

es decir,

⎧

0,

⎪

⎪

⎪

⎪

⎪

⎪

⎨

k

Fn (x) =

,

⎪n

⎪

⎪

⎪

⎪

⎪

⎩

1,

1.5.1

si

x < X1,n

si

Xk,n ≤ x < Xk+1,n

si

x ≥ Xn,n ,

k = 1, 2, . . . , n − 1

Distribución de las estadı́sticas de orden

Las estadı́sticas heredan en menor o mayor medida los rasgos del modelo elegido

para representar el comportamiento poblacional. Especı́ficamente la distribución muestral de las estadı́sticas de orden incluye de manera explı́cita las funciones de densidad y distribución de la población como lo registran los siguientes

teoremas.

Teorema 1.5.1. Siendo X1,n , X2,n , . . . , Xn,n las estadı́sticas de orden o la muestra ordenada de una población con función de distribución FX (x), entonces para

k = 1, 2, . . . , n

n n

FXk,n (y) =

[FX (y)]j [1 − FX (y)]n−j

j

j=k

Corolario 1.5.1.1. Para los casos especiales del mı́nimo y máximo de la muestra se tiene:

FX1,n (y) = 1 − [1 − FX (y)]n

FXn,n (y) = [FX (y)]n

Teorema 1.5.2. Siendo X1 , X2 , . . . , Xn una muestra aleatoria de una población

con función de distribución contı́nua FX (x), la función de densidad de la késima estadı́stica de orden es

fXk,n (y) =

n!

[FX (y)]k−1 [1 − FX (y)]n−k fX (y),

(k − 1)!(n − k)!

k = 1, 2, . . . , n

La función conjunta de densidad de la j-ésima estadı́stica de orden y la

k-ésima estadı́stica de orden fXj,n ,Xk,n (x, y) es

c(n, j, k)[FX (x)]j−1 [FX (y) − FX (x)]k−j−1 [1 − FX (y)]n−k fX (y)fX (x)I(x,∞) (y)

para 1 ≤ j < k ≤ n, con c(n, j, k) = n!/[(j − 1)!(k − j − 1)!(n − k)!]. La función

conjunta de densidad de las estadı́sticas de orden es

fX1,n ,X2,n ,... ,Xn,n (y1 , y2 , . . . , yn ) =

⎧

⎪

⎨ n!

⎪

⎩

n

fX (yi )

i=1

0

y1 < y2 < · · · < yn

en otros casos

20

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

Ejemplo 1.5.1. Siendo X1 , X2 , . . . , Xn una muestra aleatoria de una población

con distribución Uniforme en el intervalo (α, β), determinar la función de densidad de la k-ésima estadı́stica de orden.

1

I(α,β) (x)

β−α

x−α

I(α,β) (x) + I[β,∞) (x)

FX (x) =

β−α

k−1 n−k 1

y−α

n!

y−α

fXk,n (y) =

I(α,β) (y)

1−

(k − 1)!(n − k)! β − α

β−α

β−α

n

n!

1

=

(y − α)k−1 (β − y)n−k I(α,β) (y)

(k − 1)!(n − k)! β − α

fX (x) =

La distribución de la k-ésima estadı́stica de orden es la de una variable aleatoria

con distribución Beta en el intervalo (α, β) con parámetros k y (n−k+1) cuando

la población es Uniforme en el intervalo (α, β).

Nota. Una variable aletoria X con distribución Beta en el intervalo (0, 1) puede

generar una variable aleatoria Y con distribución Beta en el intervalo (α, β)

mediante la relación

Y = α + (β − α)X

Teorema 1.5.3. Sea X1 , X2 , . . . , Xn , una muestra aleatoria de una población

con función de distribución FX (x) continua. Para p fijo, si xp denota al único

percentil 100p poblacional, entonces

P [Xj,n < xp < Xk,n ] =

k−1

l=j

1.5.2

n l

p (1 − p)n−l

l

Distribución del rango, semirango y mediana muestrales

Las estadı́sticas correspondientes al rango y semirango son funciones del máximo

y mı́nimo muestrales, por lo tanto la determinación de su distribución parte de

la consideración de la distribución conjunta de X1,n y Xn,n

fX1,n ,Xn,n (x, y) = n(n − 1) [FX (y) − FX (x)]

Definidas las estadı́sticas:

R = Xn,n − X1,n

T =

X1,n + Xn,n

2

n−2

fX (x)fX (y)I(x,∞) (y)

21

1.5. ESTADÍSTICAS DE ORDEN

se considera la siguiente transformación

r

r

y =t+

x=t−

2

2

cuyo jacobiano es

∂x

∂r

∂y

∂r

∂x 1

∂t = 2

∂y 1

2

∂t

1

=1

1

con lo cual

n−2

fR,T (r, t) = n(n − 1) FX t + 2r − FX t − r2

fX t −

En consecuencia, para r > 0, se tiene

∞

fR (r) =

fR,T (r, t)dt

−∞

∞

fR,T (r, t)dr

fT (t) =

r

2

fX t −

r

2

−∞

La distribución de la mediana está dependiendo del tamaño de la muestra. Si

éste es entero impar, su distribución está totalmente determinada pues

corresponde a la distribución de la estadı́stica de orden n+1

2 . Para la situación

en la cual n es par, la mediana es función de las estadı́sticas de orden X n2 ,n y

X n2 +1,n . Ası́ al tomar n = 2m, m = 1, 2, . . .

fX n ,n ,X n +1,n (x, y) = fXm,n ,Xm+1,n (x, y)

2

2

(2m)!

[FX (x)]m−1 [1 − FX (x)]m−1 fX (x)fX (y)

[(m − 1)!]2

=

con x < y. Considerando la transformación u =

f x+y (u) = fU (u)

2

=

1.5.3

2(2m)!

[(m − 1)!]2

∞

x+y

2 ,v

= y, se tiene que

[FX (2u − v)]m−1 [1 − FX (v)]m−1 fX (2u − v)fX (v)dv

u

Distribución de la función de distribución empı́rica

La función de distribución empı́rica tiene varios usos especialmente en métodos

y conceptos de la Estadı́stica no paramétrica. Su gráfico se convierte en un

indicativo de una primera aproximación al ajuste que brinda el modelo. Algunos

aspectos de su distribución se presentan a continuación.

n

k

P Fn (x) =

=

[FX (x)]k [1 − FX (x)]n−k

n

k

donde k = 0, 1, 2, . . . , n. En efecto, denotando la variable aleatoria

Zi = I(−∞,x] (Xi )

22

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

luego Zi ∼ Ber(FX (x)), por lo tanto

n

Zi ∼ Bin(n, FX (x)) y por consiguiente

i=1

E[Fn (x)] = FX (x)

V [Fn (x)] =

FX (x)[1 − FX (x)]

n

Teorema 1.5.4. Siendo X1 , X2 , . . . , Xn una muestra aleatoria de una población

con función de distribución FX (x), entonces

P

Fn (x) −→ FX (x)

para un valor x dado.

Teorema 1.5.5 (Teorema de Glivenko-Cantelli). Si X1 , X2 , . . . , Xn es una

muestra aleatoria de una población con función de distribución FX (x), entonces

Fn (x) converge uniformemente a FX (x), esto es, para cada > 0,

lim P

sup |Fn (x) − FX (x)| < = 1

n→∞

−∞<x<∞

FX (x)

Fn (x)

|

x

Figura 1.3: Esquema de las funciones de distribución Fn (x) y FX (x)

Teorema 1.5.6. Siendo X1 , X2 , . . . , Xn una muestra aleatoria de una población

con función de distribución FX (x), la sucesión de variables aleatorias

√

n[Fn (x) − FX (x)]

FX (x)[1 − FX (x)]

converge en distribución a una variable aleatoria con distribución Normal estándar.

1.6. MOMENTOS DE ESTADÍSTICAS DE ORDEN

1.6

23

Momentos de estadı́sticas de orden

Los teoremas 1.5.1 y 1.5.2 puntualizan respectivamente la función de distribución y la función de densidad de la k-ésima estadı́stica de orden. En principio,

garantizada la existencia del momento de interés y determinada explı́citamente

la función de distribución FX (x), podrı́a formalizarse el momento con base en

las referidas funciones de distribución o de densidad. Sin embargo, su logro

depende de la complejidad de la integración requerida para su cálculo, dado que

algunas veces se alcanza únicamente por medio de integración numérica.

A manera de ejemplo, considerando el comportamiento poblacional como indiferente para cualquier valor del intervalo (0, 1), el valor esperado, la varianza

y el momento de orden r de la estadı́stica de orden k es factible determinarlos.

Ejemplo 1.6.1. Siendo X1,n , X2,n , . . . , Xn,n es una muestra ordenada de una

población con distribución Uniforme en el intervalo (0, 1)

E[Xk,n ] =

V [Xk,n ] =

k

n+1

k(n − k + 1)

(n + 2)(n + 1)2

j(n − k + 1)

ρ(Xj,n , Xk,n ) =

k(n − j + 1)

12

,

j<k

En efecto. En primer lugar, de manera general

1

n!

r

E[Xk,n ] =

xr+k−1 (1 − x)n−k dx

(k − 1)!(n − 1)! 0

n!

β(r + k, n − k + 1)

=

(k − 1)!(n − 1)!

y utilizando la relación β(a, b) =

Γ(a)Γ(b)

, entonces

Γ(a + b)

n!

Γ(r + k)Γ(n − k + 1)

(k − 1)!(n − 1)! Γ(r + k + n − k + 1)

n!(r + k − 1)!

,

1≤k≤n

=

(r + n)!(k − 1)!

r

]=

E[Xk,n

particularmente,

E[Xk,n ] =

k

n!k!

=

(n + 1)!(k − 1)!

n+1

2

] − (E[Xk,n ])2

V [Xk,n ] = E[Xk,n

k(k + 1)

n!(k + 2 − 1)!

=

(n + 2)!(k − 1)!

(n + 1)(n + 2)

k2

k(k + 1)

k(n − k + 1)

−

V [Xk,n ] =

=

2

(n + 1)(n + 2) (n + 1)

(n + 2)(n + 1)2

2

E[Xk,n

]=

24

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

Por otra parte, denotándo E[Xj,n , Xk,n ] = Δ, se tiene que

Δ=

n!

(j − 1)!(k − j − 1)!(n − k)!

=

n!

(j − 1)!(k − j − 1)!(n − k)!

Realizando la sustitución v =

1

y

xj y(y − x)k−j−1 (1 − y)n−k dxdy

0

0

y

1

n−k

j

k−j−1

y(1 − y)

x (y − x)

dx dy

0

0

x

y

1

n!

Δ=

y(1 − y)n−k y k β(j + 1, k − j) dy

(j − 1)!(k − j − 1)!(n − k)! 0

n!

β(1 + j, k − j)β(k + 2, n − k + 1)

=

(j − 1)!(k − j − 1)!(n − k)!

j(k + 1)

= E[Xj,n , Xk,n ]

=

(n + 1)(n + 2)

con lo cual

Cov(Xj,n , Xk,n ) =

jk

j(k + 1)

−

(n + 1)(n + 2) (n + 1)2

ρ(Xj,n , Xk,n ) =

j(n − k + 1)

k(n − j + 1)

j<k

j<k

por lo tanto, como caso especial, la correlación entre el mı́nimo y máximo de la

muestra bajo comportamiento poblacional Uniforme en el intervalo (0, 1) es

ρ(X1,n , Xn,n ) =

1

n

Como ya se mencionó, en algunos casos se requiere integración numérica

para determinar momentos de una estadı́stica de orden. Sin embargo es posible

presentar expresiones que permiten aproximar el valor esperado y varianza de

la k-ésima estadı́stica de orden.

El desarrollo de estas expresiones se basa en una expansión en serie de Taylor

y en el hecho de que si X es una variable aleatoria con función de distribución

FX (x) continua, la variable aleatoria Y = FX (X) tiene distribución Uniforme

en (0, 1), entonces

k

−1

E[Xk,n ] FX

n+1

k(n − k + 1)

V [Xk,n ]

2

−1

k

(n + 1)2 (n + 2) fX FX

n+1

1.7. DEMOSTRACIÓN DE LOS TEOREMAS DEL CAPÍTULO

25

Finalmente se expone una breve alusión a la distribución asintótica de las estadı́sticas de orden.

El estudio de la distribución asintótica de la k-ésima estadı́stica de orden

incluye dos casos a saber: el primero cuando n tiende a infinito y nk permanece

fijo, el segundo cuando n tiende a infinito y k o n − k permanecen finitos.

Para algunos efectos, el primer caso es de mayor interés; el teorema siguiente

se adscribe a ese caso.

Teorema 1.6.1. Sea X1 , X2 , . . . , Xn una muestra aleatoria de una población

cuya función de distribución FX (x) es estrictamente monótona. Asumiendo que

xp es el percentil 100p poblacional, es decir, FX (xp ) = p, entonces la estadı́stica

de orden [np] + 1 tiene distribución asintótica Normal con valor esperado xp y

varianza n[fp(1−p)

2.

X (xp )]

Particularmente, si p = 12 (mediana) y la población es Normal con valor

esperado μ y varianza σ 2 la mediana muestral tiene distribución Normal con

2

valor esperado μ y varianza πσ

2n .

Con este teorema relativo a la distribución asintótica de la k-ésima estadı́stica

de orden concluye la introducción a las ideas preliminares de la Inferencia estadı́stica, presentación que además entreabre el contexto filosófico en el cual

se desempeña, que describe las caracterı́sticas más relevantes de algunas estadı́sticas y registra como estadı́sticas especiales a las estadı́sticas de orden.

Con esto se da paso a la exposición de los argumentos que sustentan las afirmaciones de los enunciados de los teoremas relacionados y finalmente a la serie de

ejercicios cuyo desarrollo complementará la reflexión sobre estos temas iniciales

y será un componente más en la aprehensión de los conceptos expuestos en este

primer capı́tulo.

1.7

Demostración de los teoremas del capı́tulo

Demostración (Teorema 1.3.1). Algunos apartes de la demostración pueden

consultarse en A first course in mathematical statistics, de G. Roussas, páginas

133 a 135 y en Basic probability theory de R. Ash, páginas 204 y 205.

p

Demostración (Teorema 1.3.4). Suponiendo que Xn −

→ c, entonces para

>0

lim P [|Xn − c| < ] = 1 = lim P [c − < Xn < c + ]

n→∞

n→∞

= lim [Fn (c + ) − Fn (c − )]

n→∞

= lim [Fn (c + )] − lim [Fn (c − )]

n→∞

n→∞

La imagen de cualquier función de distribución es un valor que pertenece al

intervalo [0, 1], luego la única posibilidad para que la igualdad anterior se de es

que

lim Fn (c + ) = 1

n→∞

y

lim Fn (c − ) = 0

n→∞

26

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

hecho revelador de que Fn (x) −→ F (x) siendo F (x) una función de distribución

tal que

0 si x < c

F (x) =

1 si x ≥ c

es decir que F (x) es la función de distribución de una constante c.

Suponiendo ahora que Fn (x) −→ F (x) con F (x) = I[c,∞) (x), es decir que

lim Fn (x) = F (x)

n→∞

entonces

lim Fn (c − ) = 0 para > 0 y lim Fn (c + ) = 1

n→∞

n→∞

luego

lim [Fn (c + ) − Fn (c − )] = 1 = lim P [c − < Xn < c + ]

n→∞

n→∞

= lim P [|Xn − c| < ]

n→∞

p

lo cual significa que Xn −

→ c.

Demostración (Teorema 1.4.1). El valor esperado del momento ordinario

de orden r puede determinarse mediante dos argumentos. En primer lugar,

utilizando las propiedades del valor esperado se tiene que

1 r

1

Xi =

E[Xir ],

n i=1

n i=1

n

]=E

E[Mr,n

n

r = 1, 2, . . .

En segundo lugar, como todas las variables aleatorias de la sucesión tienen la

misma distribución, por constituir una muestra aleatoria, E[Xir ] = μr , para

i = 1, 2, . . . , n, en consecuencia

1 1

μ = (nμr ) = μr

n i=1 r

n

n

E[Mr,n

]=

De manera similar puede determinarse la varianza del momento ordinario de

orden r. De las propiedades de la varianza, se puede afirmar que

]=V

V [Mr,n

n

n

1 r

1

Xi = 2 V

Xir ,

n i=1

n

i=1

r = 1, 2, . . .

y debido a que las variables aleatorias son independientes, pues constituyen una

muestra aleatoria, lo son también las variables X1r , X2r , . . . , Xnr , con lo cual

V

]

[Mr,n

n

n

1 1 2

r

E[Xi2r ] − (E[Xir ])

= 2

V [Xi ] = 2

n i=1

n i=1

27

1.7. DEMOSTRACIÓN DE LOS TEOREMAS DEL CAPÍTULO

y como las variables tienen distribución idéntica,

V [Mr,n

]=

n

1 1 μ − (μr )2

μ2r − (μr )2 =

2

n i=1

n 2r

Demostración (Teorema 1.4.2). Para determinar el valor esperado de la

varianza muestral, es necesario previamente verificar la identidad:

n

(Xi − μ)2 = (n − 1)Sn2 + n(X n − μ)2

i=1

El sumar y restar X n es el punto de partida en la verificación de la identidad,

de tal manera que

n

(Xi − μ)2 =

i=1

n

(Xi − X n + X n − μ)2 =

i=1

n

(Xi − X n ) + (X n − μ)

2

i=1

Asimismo después de desarrollar el cuadrado indicado,

n

(Xi − μ)2 =

i=1

n

(Xi − X n )2 + 2(X n − μ)

i=1

=

n

n

(Xi − X n ) + n(X n − μ)2

i=1

(Xi − X n )2 + n(X n − μ)2

i=1

porque

n

(Xi − X n ) =

i=1

n

Xi − nX n = nX n − nX n = 0, y por lo tanto

i=1

n

(Xi − μ)2 = (n − 1)Sn2 + n(X n − μ)2

i=1

Con el anterior recurso,

1 n

(X n − μ)2

(Xi − μ)2 −

n − 1 i=1

n−1

n

1

=

E[(Xi − μ)2 ] − nE[(X n − μ)2 ]

n − 1 i=1

n

E[Sn2 ] = E

como E[(Xi − μ)2 ] = V [Xi ], E[(X n − μ)2 ] = V [X n ] y teniendo en cuenta que

todas las variables aleatorias de la sucesión tienen la misma distribución,

E[Sn2 ] =

2

n

1

σ

1

[nσ 2 − σ 2 ] = σ 2

σ2 − n

=

n − 1 i=1

n

n−1

La demostración del segundo enunciado del teorema, es uno de los ejercicios de

este capı́tulo.

28

CAPÍTULO 1. DISTRIBUCIONES MUESTRALES

Demostración (Teorema 1.4.3). La herramienta procedente para sustentar

el desarrollo de esta demostración será la desigualdad de Chevyshev, la cual

2

asegura que si X es una variable aleatoria con valor esperado μX y varianza σX

finita,

P [|X − μX | < rσX ] ≥ 1 −

1

r2

para cada r > 0

Aplicando la desigualdad al caso especial de la variable aleatoria X n , teniendo en

σ2

, como lo manifiesta el corolario 1.4.1.1,

cuenta que E[X n ] = μ y V [X n ] =

n

σ

1

P Xn − μ < r √

para cada r > 0

≥1− 2

n

r

utilizando el reemplazo = r √σn se tiene que > 0 y

σ2

P [X n − μ < ] ≥ 1 − 2

n

de tal manera que

σ2

lim P [X n − μ < ] ≥ lim 1 − 2 = 1

n→∞

n→∞

n

es decir que

lim P [X n − μ < ] = 1

n→∞

p

→ μ, como lo afirma la ley débil de los grandes números.

lo cual significa que X n −

σ2

Nota. La cota 1 − 2 crece en cuanto n crece. Si se fija la cota en 1 − δ,

n

0 < δ < 1, significa que existe un tamaño de muestra mı́nimo n, para el cual

σ2

P [|X n − μ| < ] ≥ 1 − δ. Dicho en otros términos 1 − 2 > 1 − δ, es decir,

n

P [− < X n − μ < ] ≥ 1 − δ, para n >

σ2

δ2

Demostración (Teorema 1.4.4). Utilizando la función generatriz de momentos de la variable que representa a la población MX (t), o en su defecto la función

caracterı́stica φX (t),

t

t

t

tX n

= E exp

X1 + X2 + · · · + Xn

MX n (t) = E e

n

n

n

como las variables constituyen una muestra aleatoria,

n

MX n (t) =

E e

i=1

t

n Xi

n

t t

X

n

=

= MX

E e

n

i=1

n

1.7. DEMOSTRACIÓN DE LOS TEOREMAS DEL CAPÍTULO

entonces

μ

MX n (t) = 1 +

1!

2

t

t

1

+ ···

+ E[X 2 ]

n

2!

n

29

n

n

t

μt

+O

= eμt

1+

n→∞

n

n

lim MX n (t) = lim

n→∞

función generatriz que corresponde a la función generatriz de una constante μ.

(O es el sı́mbolo “o pequeña”usado en el estudio de las series). Lo cual significa

que

d

Xn −

→μ

y con base en el teorema 1.3.4 se tiene que

p

Xn −

→μ

Demostración (Teorema 1.4.5). Como la sucesión X1r , X2r , . . . , Xnr conforma un conjunto de variables aleatorias independientes e idénticamente distribuidas porque la sucesión X1 , X2 , . . . , Xn es una muestra aleatoria, entonces